O que é o Crawl Budget?

O orçamento de rastreamento é a quantidade de tempo e recursos que os bots dos mecanismos de pesquisa alocam para rastrear seu site e indexar suas páginas.

Pense da seguinte forma: você visita o Louvre, que tem centenas de exposições em vários andares.

Sem um mapa, você pode perder a arte que realmente gostaria de ver.

Para fazer o mapa que você tem em suas mãos, alguém teria que percorrer cada sala, marcando quais pinturas estavam listadas ali.

Nessa metáfora, o criador de mapas do Louvre é como um Googlebot rastreando um site.

Uma equipe de cartógrafos correndo constantemente pelo Louvre tornaria a experiência dos espectadores mais lenta.

Da mesma forma que os bots que rastreiam constantemente seu site o tornam mais lento.

Portanto, os criadores de mapas precisam de um tempo definido para atualizar o mapa, assim como o Googlebot precisa saber com que frequência deve rastrear o seu site.

Os orçamentos de rastreamento afetam o SEO?

O orçamento de rastreamento não é um fator de classificação para SEO técnico.

Porém, se o Googlebot apresentar erros de rastreamento que o impeçam de ler e indexar seu conteúdo, as chances de suas páginas aparecerem nas páginas de resultados de mecanismos de pesquisa(SERPs) serão pequenas.

Você também não quer que os robôs do Google rastreiem seu site o tempo todo.

Exceder o orçamento alocado para o rastreamento de um site pode causar lentidão ou erros no sistema.

Isso pode fazer com que as páginas sejam indexadas com atraso ou não sejam indexadas, resultando em classificações de pesquisa mais baixas.

O Google usa centenas de sinais para decidir onde deve colocar sua página. O rastreamento determina se a sua página será exibida - e não onde - e não tem nada a ver com conteúdo de qualidade.

Como o Google determina o orçamento de rastreamento?

Cada site tem um orçamento de rastreamento exclusivo controlado por dois elementos principais: demanda de rastreamento e limite de rastreamento.

É importante que você entenda como eles funcionam e o que acontece nos bastidores.

Demanda de rastreamento

A demanda de rastreamento refere-se ao desejo que o Google tem de rastrear o seu site.

Dois fatores afetam essa demanda: popularidade e obsolescência.

Popularidade

O Google prioriza as páginas com mais backlinks ou aquelas que atraem mais tráfego. Portanto, se as pessoas estiverem visitando seu site ou criando links para ele, o algoritmo do Google receberá sinais de que seu site merece ser rastreado com mais frequência.

Os backlinks ajudam especialmente o Google a descobrir quais páginas valem a pena ser rastreadas. Se o Google perceber que as pessoas estão falando sobre o seu site, ele vai querer rastreá-lo mais para ver o que está acontecendo.

Observe que o número de backlinks por si só não importa - os backlinks devem ser relevantes e de fontes confiáveis.

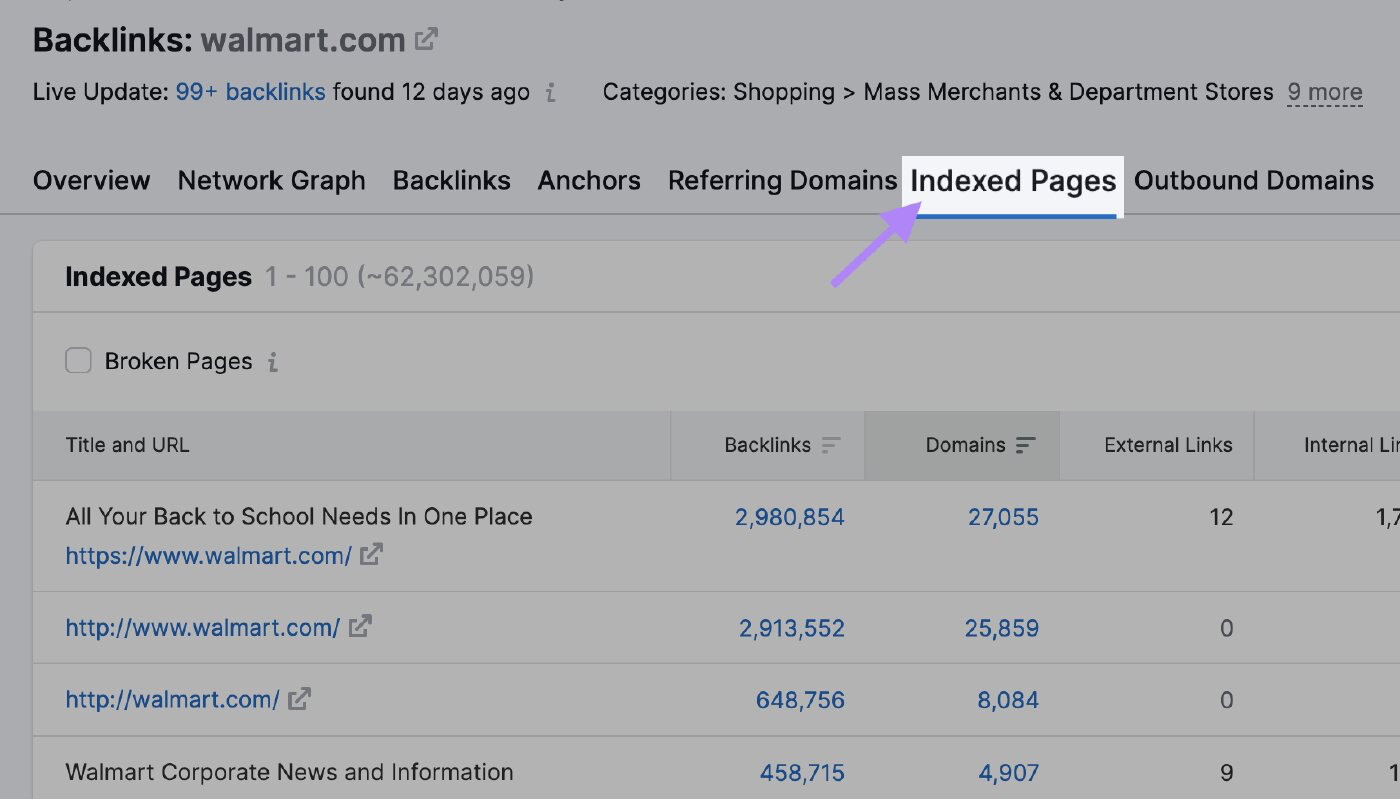

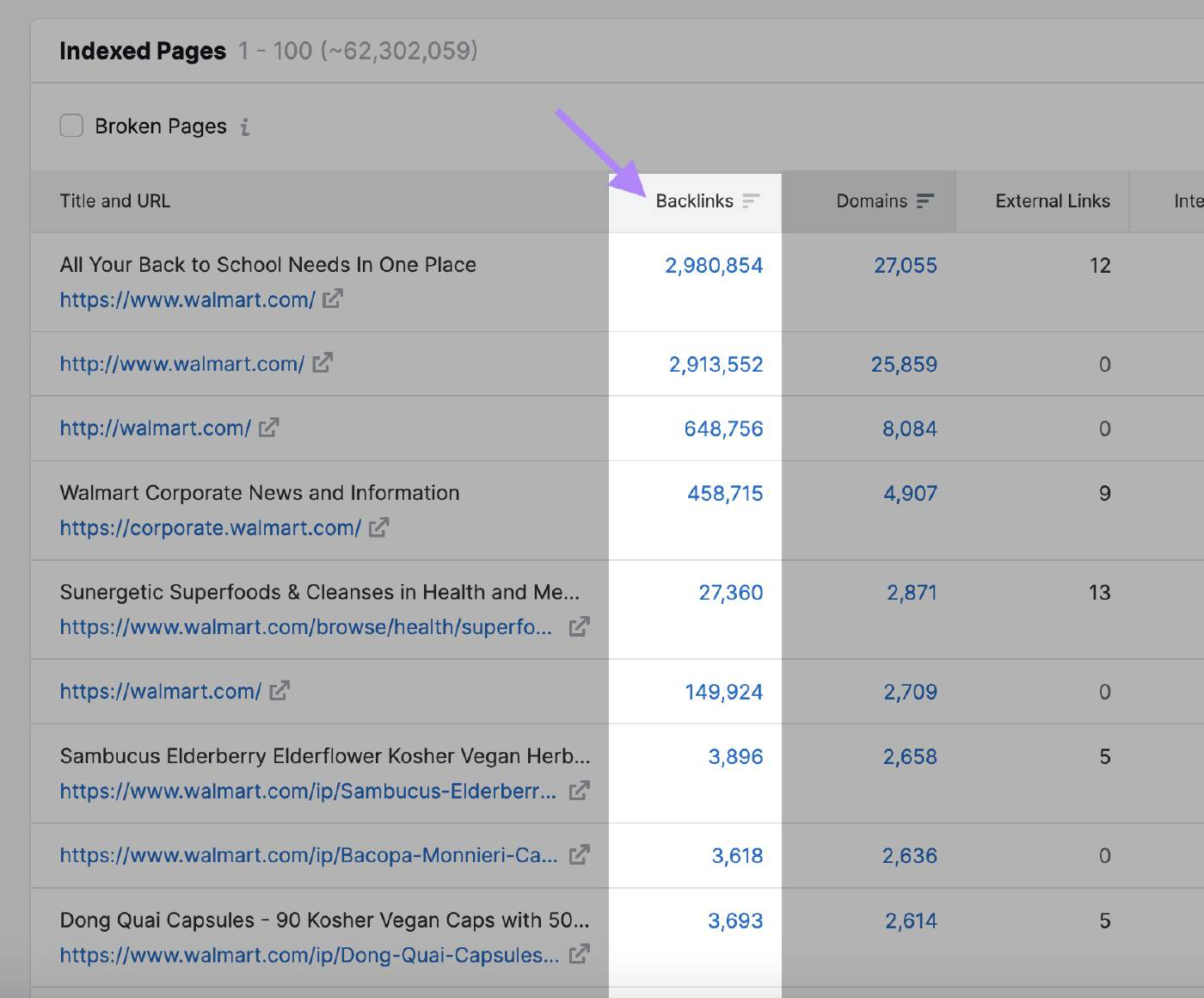

Você pode usar a ferramenta Backlink Analytics da Semrush para ver quais páginas atraem mais backlinks e podem atrair a atenção do Google. Digite o domínio e clique na guia "Páginas indexadas".

Aqui você pode ver as páginas com o maior número de backlinks:

Estagnação

O Googlebot não rastreará uma página que não tenha sido atualizada há algum tempo.

O Google não revelou a frequência com que o mecanismo de pesquisa rastreará o site novamente. No entanto, se o algoritmo perceber uma atualização geral do site, os bots aumentarão temporariamente o orçamento de rastreamento.

Por exemplo, o Googlebot rastreia sites de notícias com frequência porque eles publicam novos conteúdos várias vezes ao dia.

Nesse caso, o site tem alta demanda de rastreamento.

Compare isso com um site sobre a história de obras de arte famosas que não é atualizado com tanta frequência.

Outras ações que podem indicar ao Google que há alterações a serem rastreadas incluem:

- Mudança de nome de domínio: Quando você altera o nome de domínio do seu site, o algoritmo do Google precisa atualizar seu índice para refletir o novo URL. Ele rastreará o site para entender a alteração e passará os sinais de classificação para o novo domínio.

- Alteração da estrutura do URL: Se você modificar a estrutura de URL do seu site alterando a hierarquia do diretório ou removendo ou adicionando subdomínios, os bots do Google precisarão rastrear novamente as páginas para indexar os novos URLs corretamente

- Atualizações de conteúdo: Atualizações significativas no conteúdo do seu site, como reescrever uma grande parte das páginas, adicionar novas páginas ou remover conteúdo desatualizado, podem atrair a atenção do algoritmo e fazer com que ele rastreie novamente o seu site

- Envio do mapa do site XML: Atualizar o mapa do site XML e enviá-lo novamente ao Google Search Console pode informar ao Google que há alterações a serem rastreadas. Isso é particularmente útil quando você deseja garantir que o Google indexe páginas novas ou atualizadas prontamente.

Limite de taxa de rastreamento

O limite da taxa de rastreamento determina a velocidade com que o bot pode acessar e baixar páginas da Web do seu site para preparar o conteúdo para ser exibido nos resultados de pesquisa.

Essa é a maneira de o Google garantir que o rastreamento não sobrecarregue seus servidores.

O limite de rastreamento impede que o bot sobrecarregue seu site com muitas solicitações, o que pode causar problemas de desempenho.

Se o seu site responder rapidamente, o Google receberá sinal verde para aumentar o limite e poderá usar mais recursos para rastreá-lo.

Da mesma forma, se o Google encontrar erros no servidor ou se o seu site ficar lento, o limite cairá e o Googlebot rastreará menos o site.

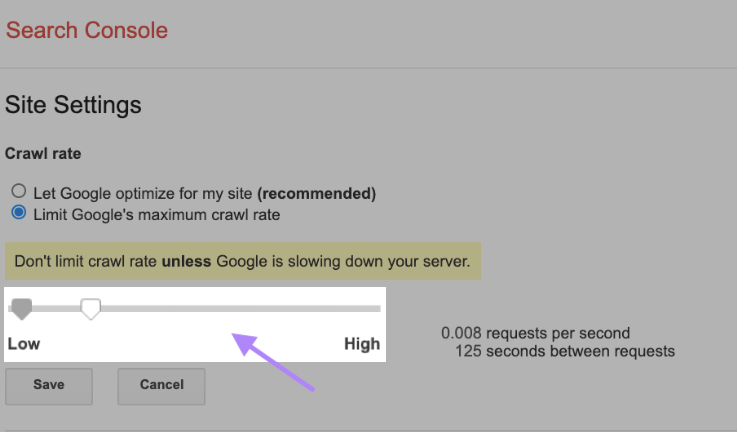

Você também pode alterar o limite de rastreamento manualmente, embora seja importante fazer isso com cautela. O Google sugere que você não limite a taxa de rastreamento, a menos que seu servidor esteja ficando lento.

Para alterar sua taxa de rastreamento, vá para Configurações do site no Search Console e ajuste a barra. Normalmente, o ajuste leva até dois dias para ser aplicado.

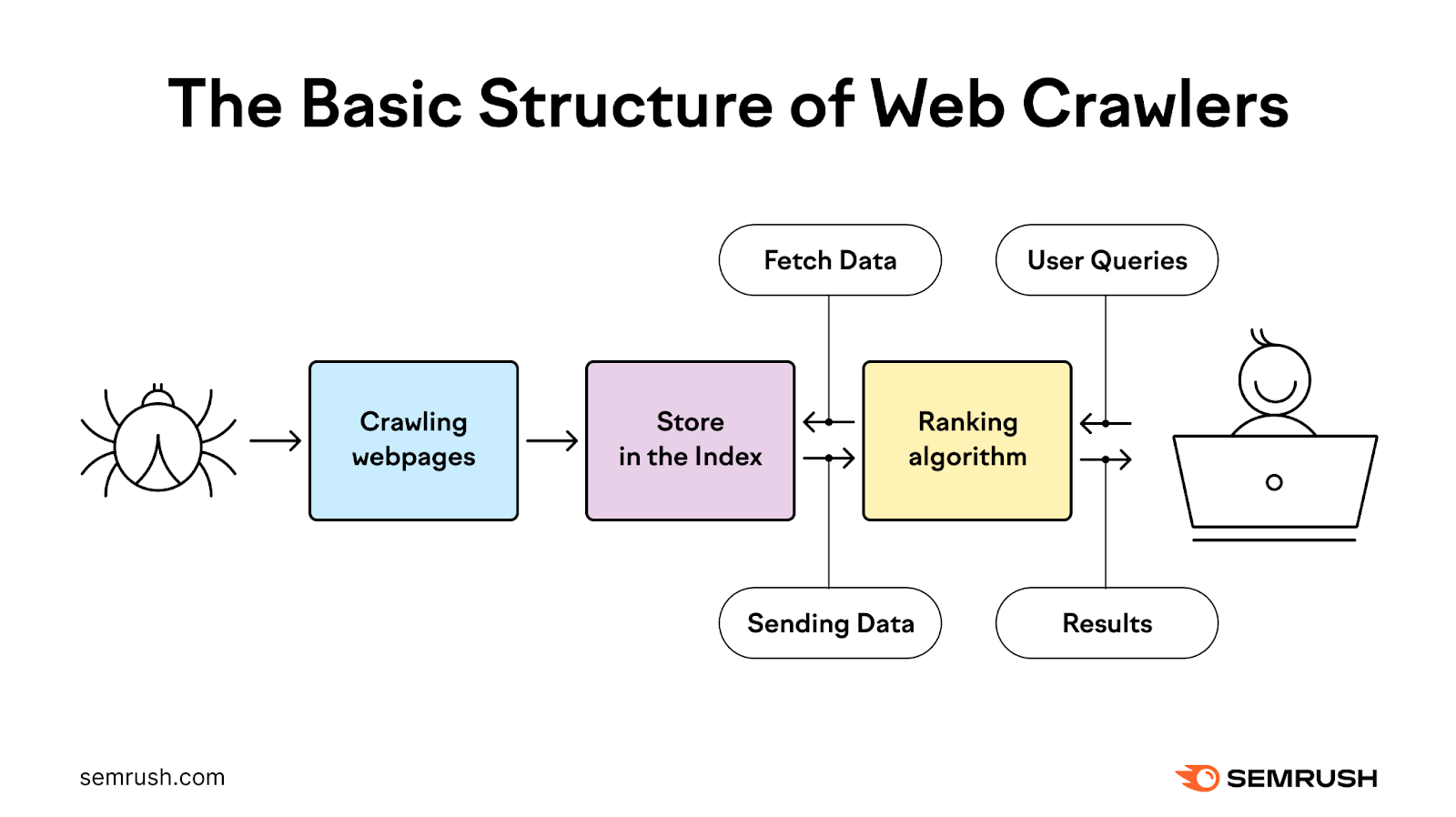

Como funciona o processo de rastreamento?

O processo de rastreamento usa bots para descobrir, rastrear, analisar e indexar páginas da Web para fornecer aos usuários os resultados de pesquisa mais relevantes e de alta qualidade.

Ele começa com uma lista de endereços da Web de rastreamentos anteriores e sitemaps XML fornecidos pelos proprietários de sites. Em seguida, o Google usa rastreadores da Web para visitar esses endereços, ler as informações e seguir os links nessas páginas.

Os rastreadores revisitam as páginas que o Google já tem na lista para verificar se elas foram alteradas e também rastreiam novas páginas.

Durante esse processo, o bot prioriza quando e o que rastrear com base na demanda de rastreamento e, ao mesmo tempo, garante que o site possa lidar com as solicitações do servidor que ele faz.

Em seguida, ele processa e passa as páginas que rastreia com êxito para o Google para indexação nos resultados de pesquisa.

Na maioria das vezes, o Google rastreia sites menores com eficiência.

Quando se trata de sites grandes com milhões de URLs, o Google precisa priorizar quando e o que rastrear e quantos recursos deve dedicar.

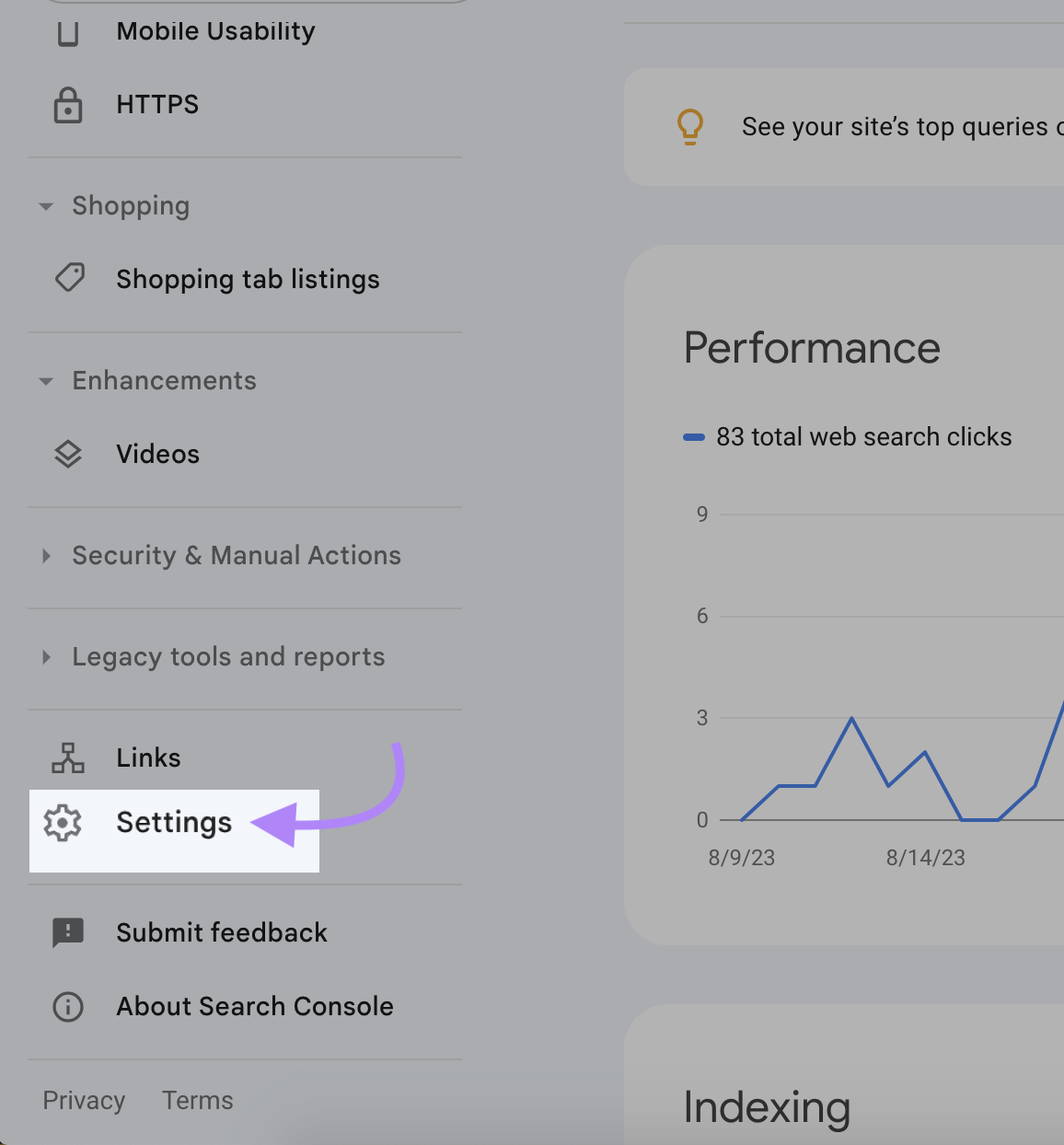

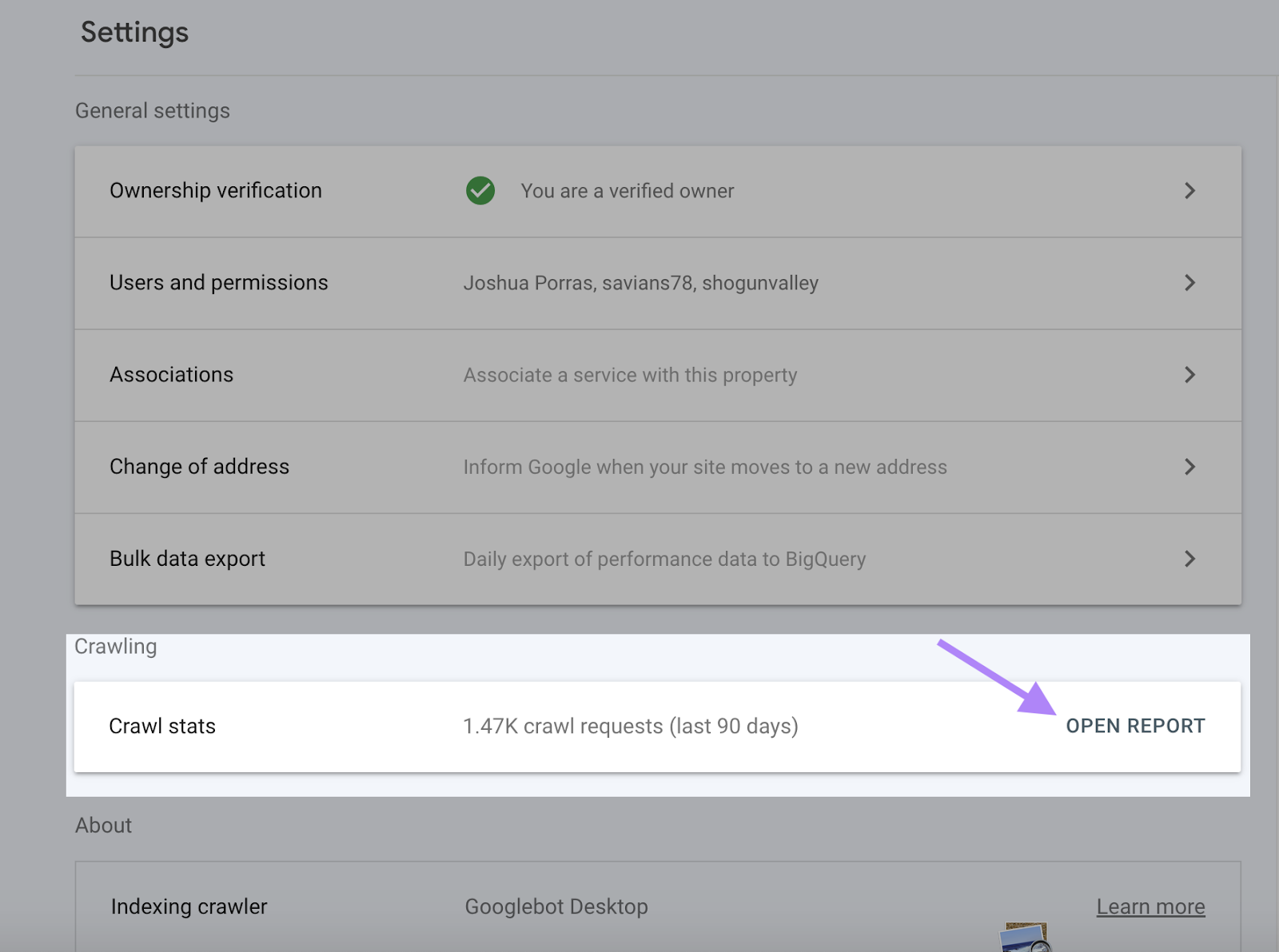

Como verificar sua atividade de rastreamento

O Google Search Console fornece informações completas sobre sua atividade de rastreamento, incluindo erros de rastreamento e taxa de rastreamento, no Relatório de estatísticas de rastreamento.

O Relatório de estatísticas de rastreamento ajuda você a verificar se o Google pode acessar e indexar seu conteúdo. Ele também pode identificar e corrigir qualquer problema antes que a visibilidade do seu site caia.

Para acessar o Relatório de estatísticas de rastreamento, faça login no Search Console e clique em "Configurações".

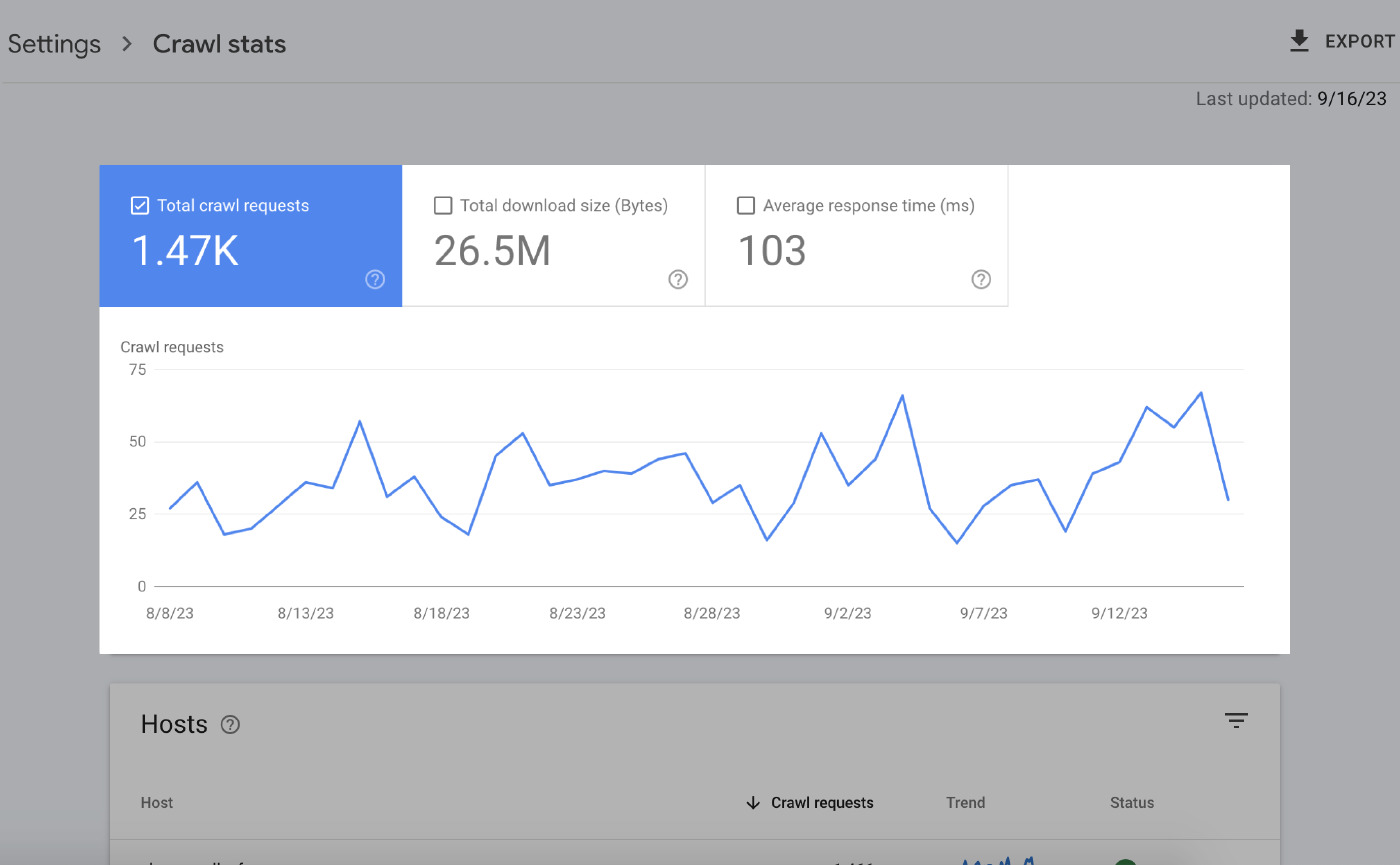

A página Resumo fornece a você muitas informações. Os principais elementos são:

Gráficos de horas extras

Os gráficos de tempo extra destacam seus dados de rastreamento nos últimos 90 dias.

O que isso significa é o seguinte:

- Total de solicitações de rastreamento: O número de solicitações de rastreamento feitas pelo Google nos últimos 90 dias.

- Tamanho total do download: A quantidade total de dados que os rastreadores do Google baixaram ao acessar seu site em um período específico.

- Tempo médio de resposta: A quantidade de tempo que o servidor do seu site leva para responder a uma solicitação do navegador de um usuário.

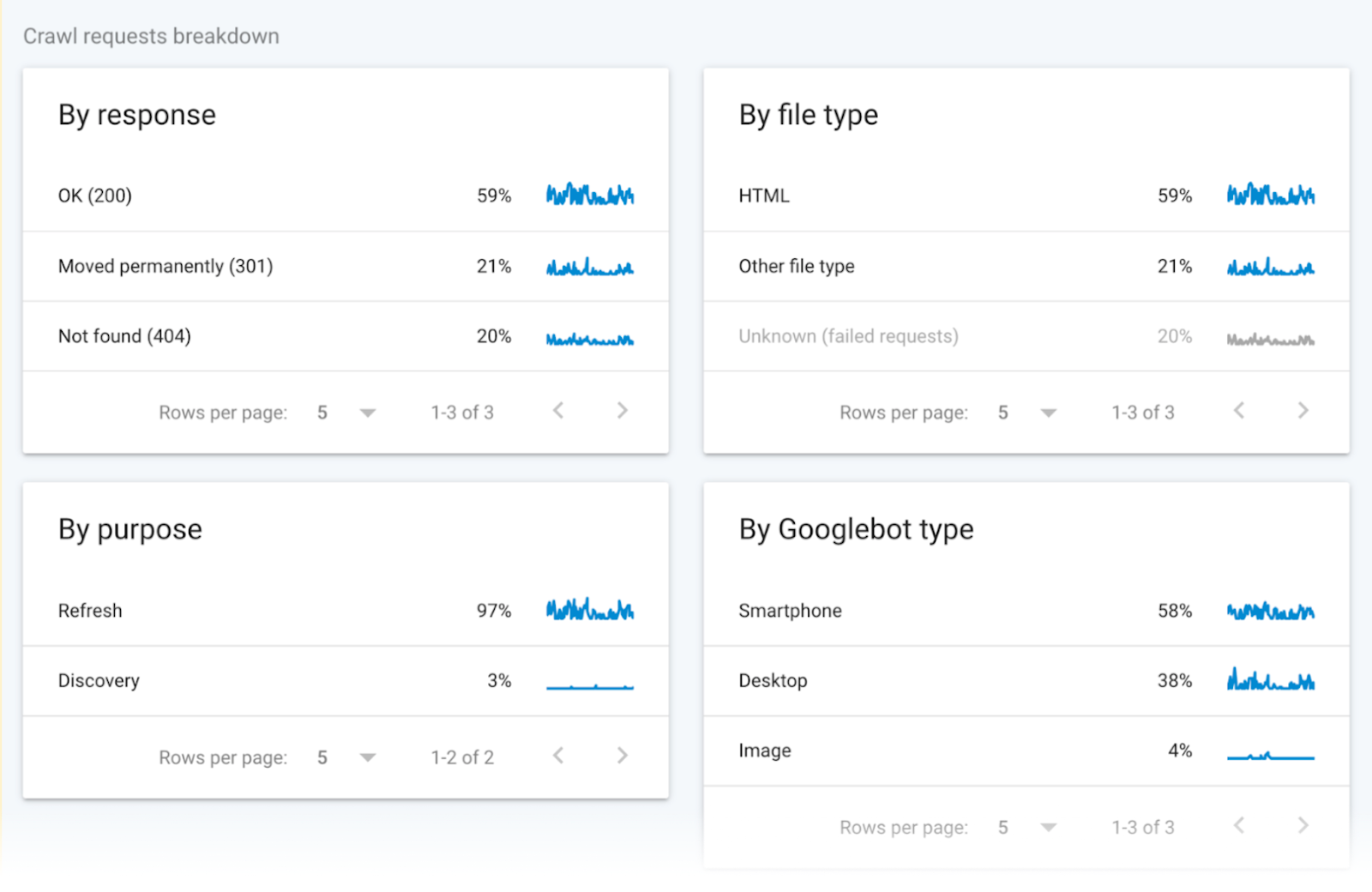

Dados de rastreamento agrupados

Os dados de rastreamento agrupados fornecem informações sobre as solicitações de rastreamento.

Os dados dividem essas solicitações de acordo com o tipo de arquivo de URL, a resposta, o tipo de Googlebot e a finalidade da solicitação (descoberta de uma nova página ou atualização de uma página existente).

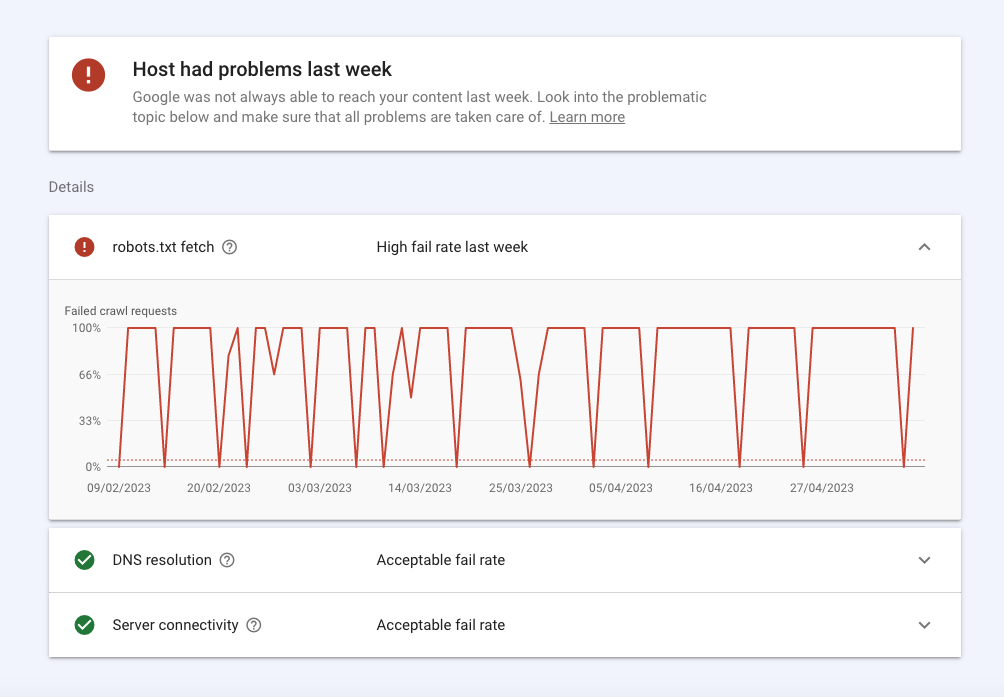

Status do host

O status do host mostra a disponibilidade geral do seu site e se o Google pode acessá-lo sem problemas.

A seguir, veja um resumo:

- Erros na seção robots.txt significam que o Google não conseguiu rastrear o seu site por algum motivo técnico. O Robots.txt fetch informa a você a taxa de falha que os bots tiveram quando rastrearam seu arquivo robots.txt. Embora seu site não precise de um arquivo robots.txt, ele deve retornar a resposta bem-sucedida 200 ou 404 quando solicitado. Se o Googlebot tiver um problema de conexão, como um status HTTP 503, ele deixará de rastrear seu site.

- A resolução de DNS informa a você quando o servidor DNS não reconheceu seu nome de host ou não respondeu durante o rastreamento. Se você encontrar um problema aqui, entre em contato com o seu registrador para verificar se o seu site está configurado corretamente e se o servidor tem uma conexão ativa com a Internet.

- A conectividade do servidor informa a você quando o servidor não estava respondendo ou não forneceu a resposta completa. Se você estiver observando picos ou problemas consistentes de conectividade aqui, talvez seja necessário conversar com seu provedor para aumentar a capacidade ou corrigir problemas de disponibilidade.

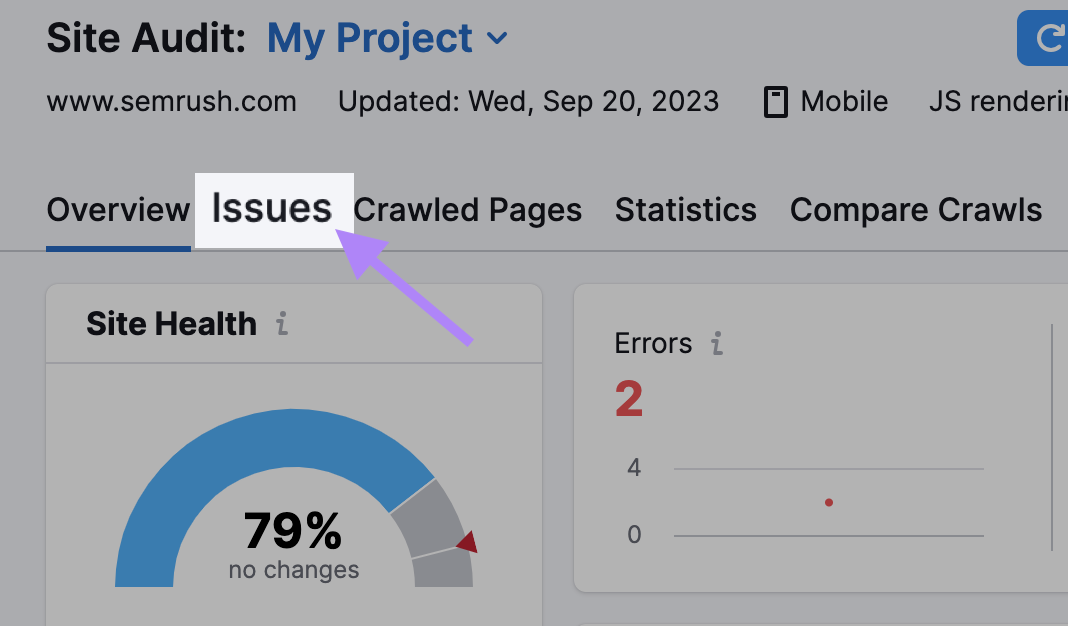

Como verificar a capacidade de rastreamento do seu site com a Auditoria do site

Use a ferramenta Auditoria do site para que os SemrushBots rastreiem seu site e verifiquem sua integridade.

A ferramenta sinaliza mais de 140 problemas, incluindo conteúdo duplicado e links quebrados, que você pode identificar e corrigir.

Aqui está o que você precisa fazer:

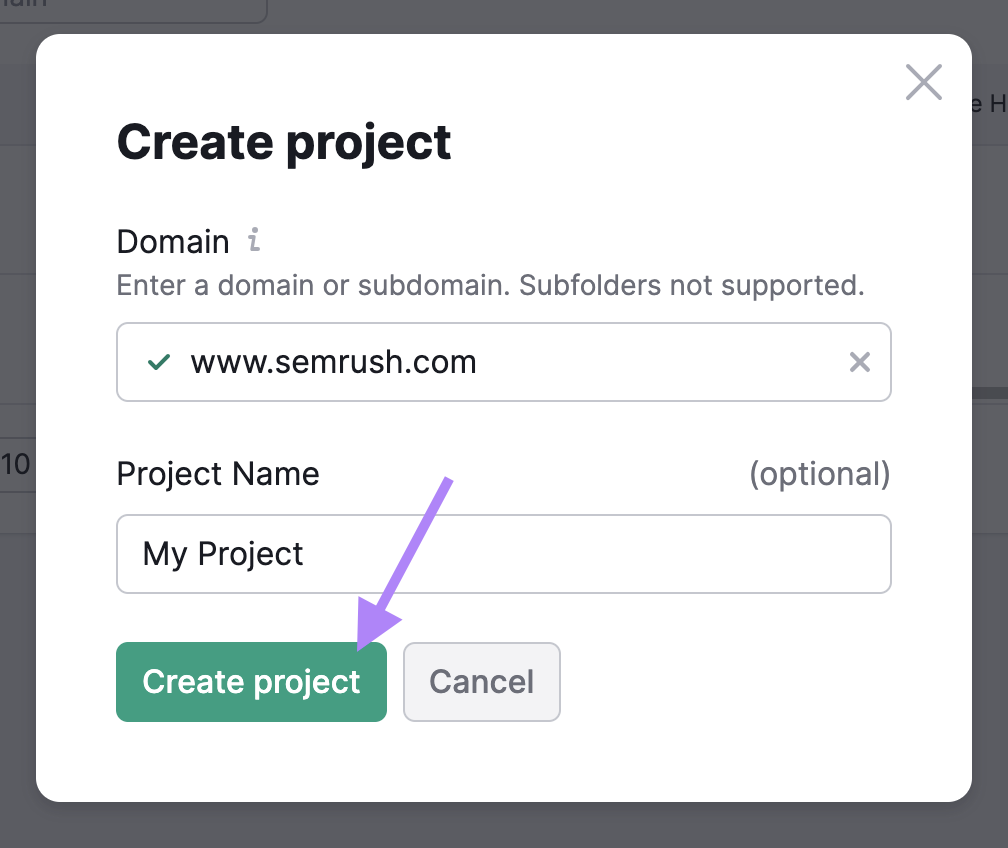

Finalizar configurações básicas

Vá para a ferramenta Auditoria do site e crie um novo projeto se esta for a primeira auditoria que você faz.

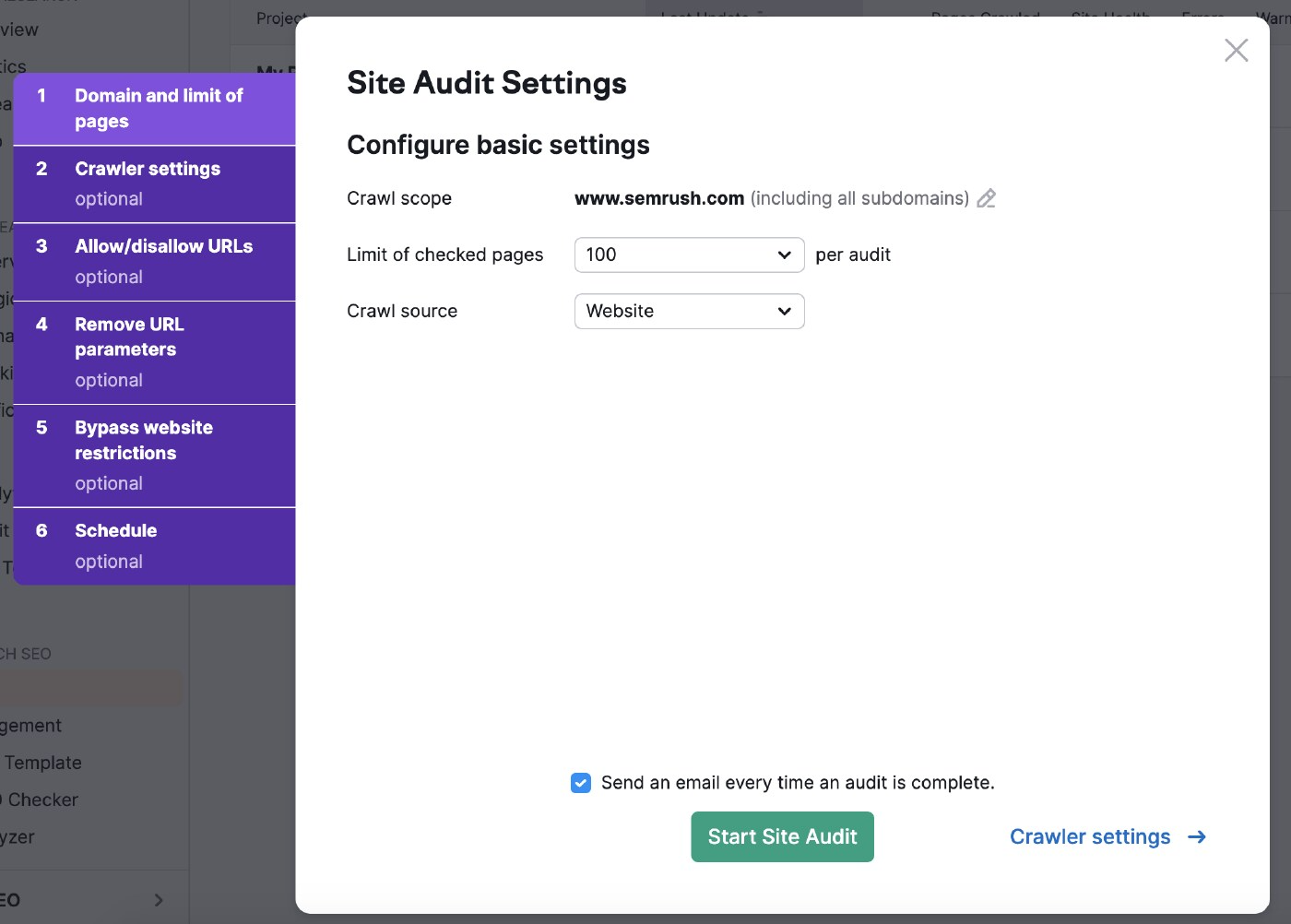

Em seguida, selecione as configurações de auditoria do site.

O escopo do rastreamento permite que você restrinja sua pesquisa.

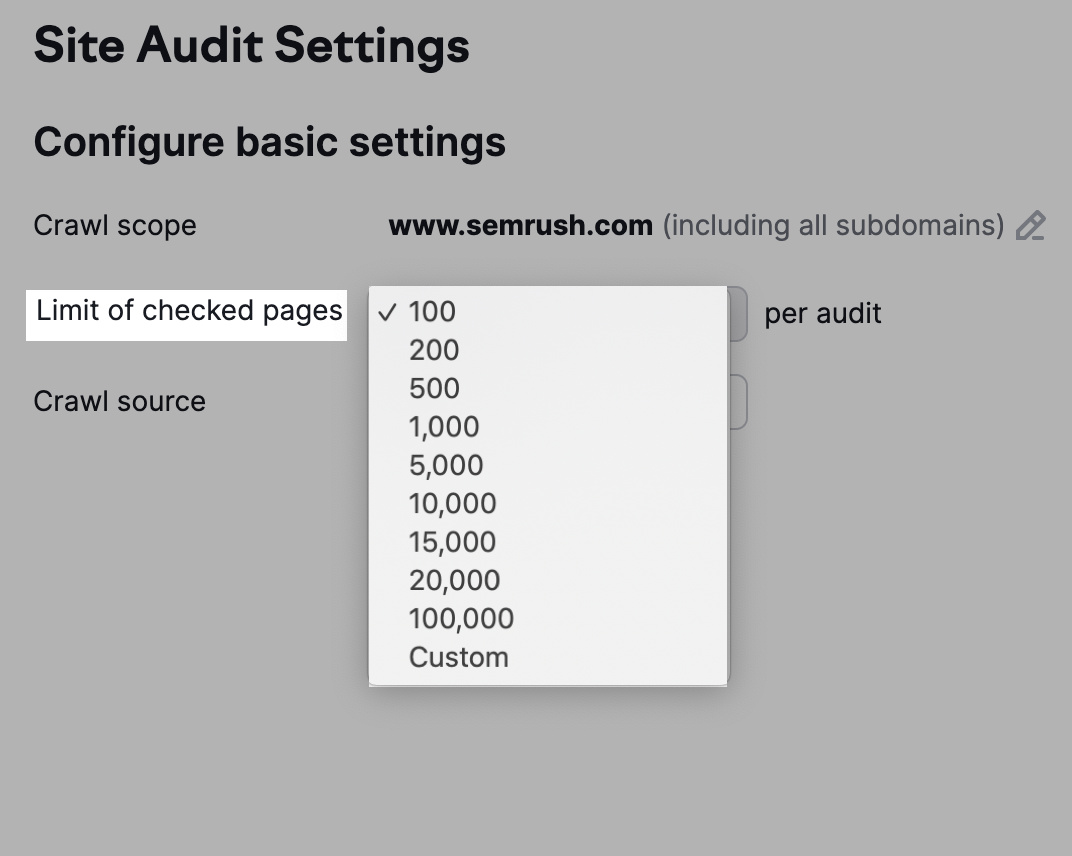

Você também pode ajustar o número de URLs a serem verificados por auditoria com base no seu nível de assinatura e na frequência com que inspeciona o site.

Quanto mais páginas você rastrear, maior será sua visibilidade.

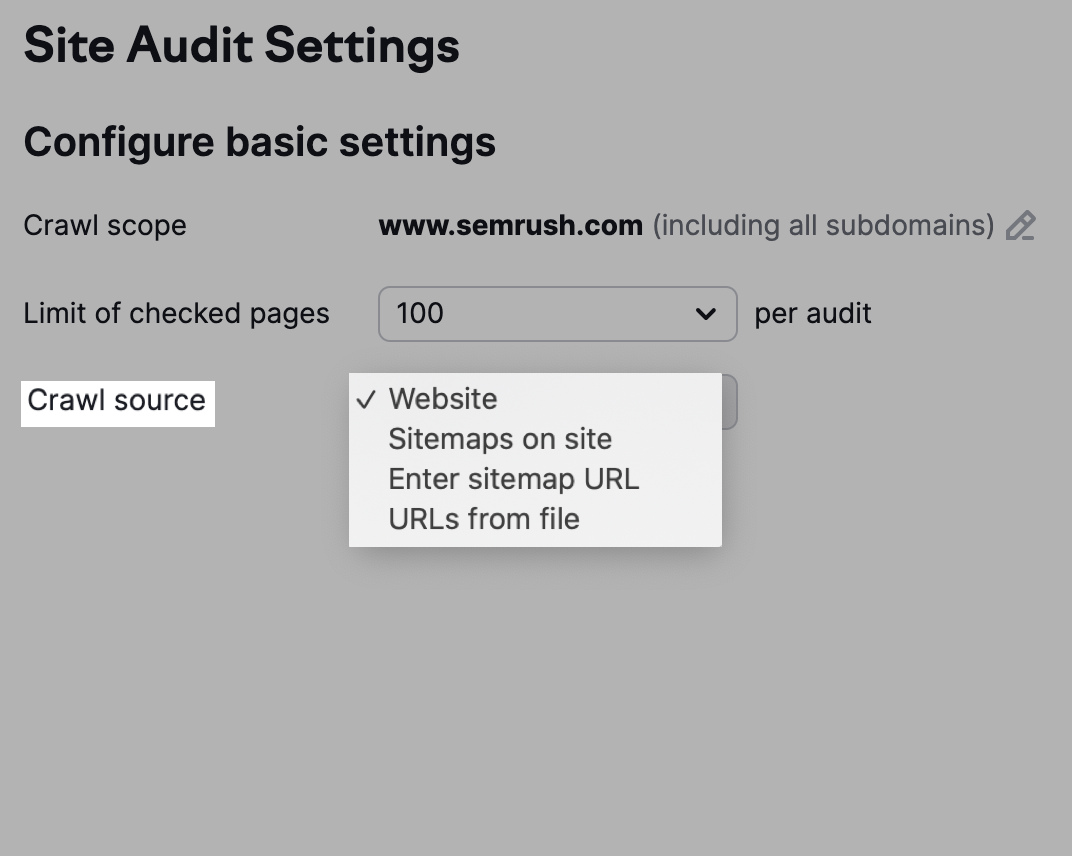

Você também tem a opção de escolher sua fonte de rastreamento.

Observe que a opção "Website" fará com que os bots rastreiem seu site como o Google faz, enquanto um rastreamento que utiliza "Sitemaps no site" usa os URLs no mapa do site do arquivo robots.txt.

Como alternativa, clique em "URLs from file" (URLs do arquivo) para selecionar as páginas que você deseja que os bots rastreiem.

Ajustar as configurações do rastreador

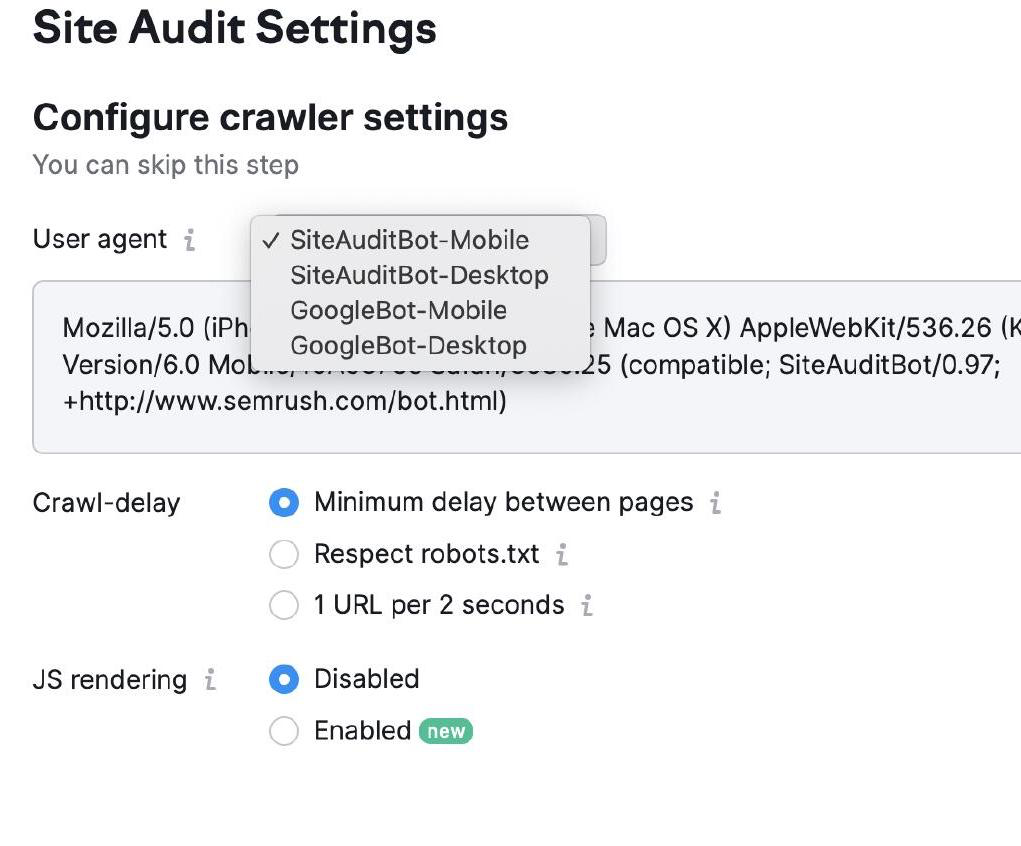

As configurações do rastreador permitem que você escolha o tipo de bot para rastrear seu site.

Você pode escolher entre Googlebot e SemrushBot e versões para celular e desktop.

Em seguida, selecione as configurações de Crawl-Delay. Os bots rastreiam a uma velocidade normal com "atraso mínimo" e priorizam a experiência do usuário nas configurações de "1 URL por 2 segundos".

Por fim, selecione "Respect robots.txt" se você tiver o arquivo relevante e precisar de um atraso de rastreamento específico.

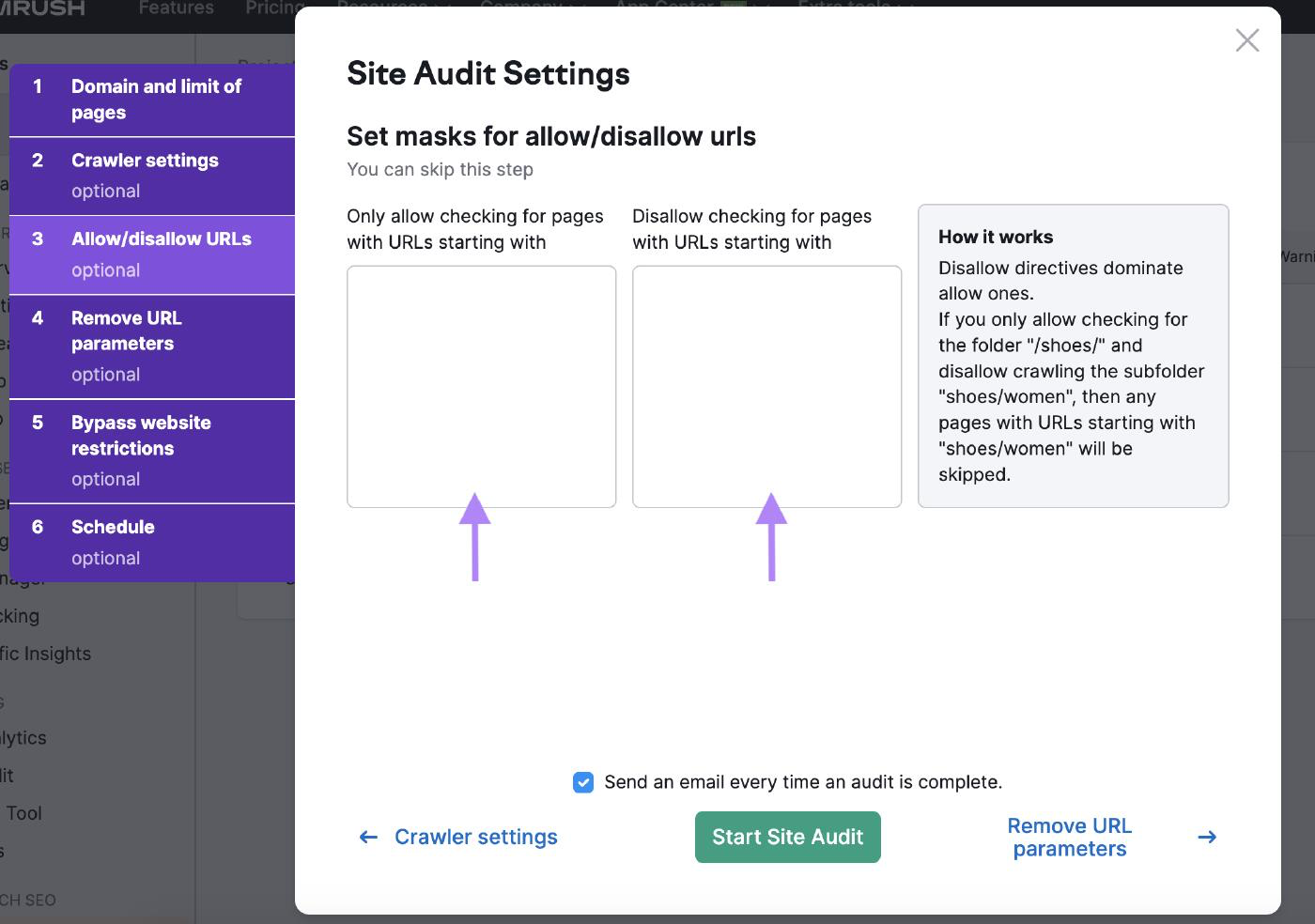

Permitir/negar URLs

Personalize a auditoria do seu site com as configurações de permitir/negar URLs inserindo os URLs nas caixas correspondentes.

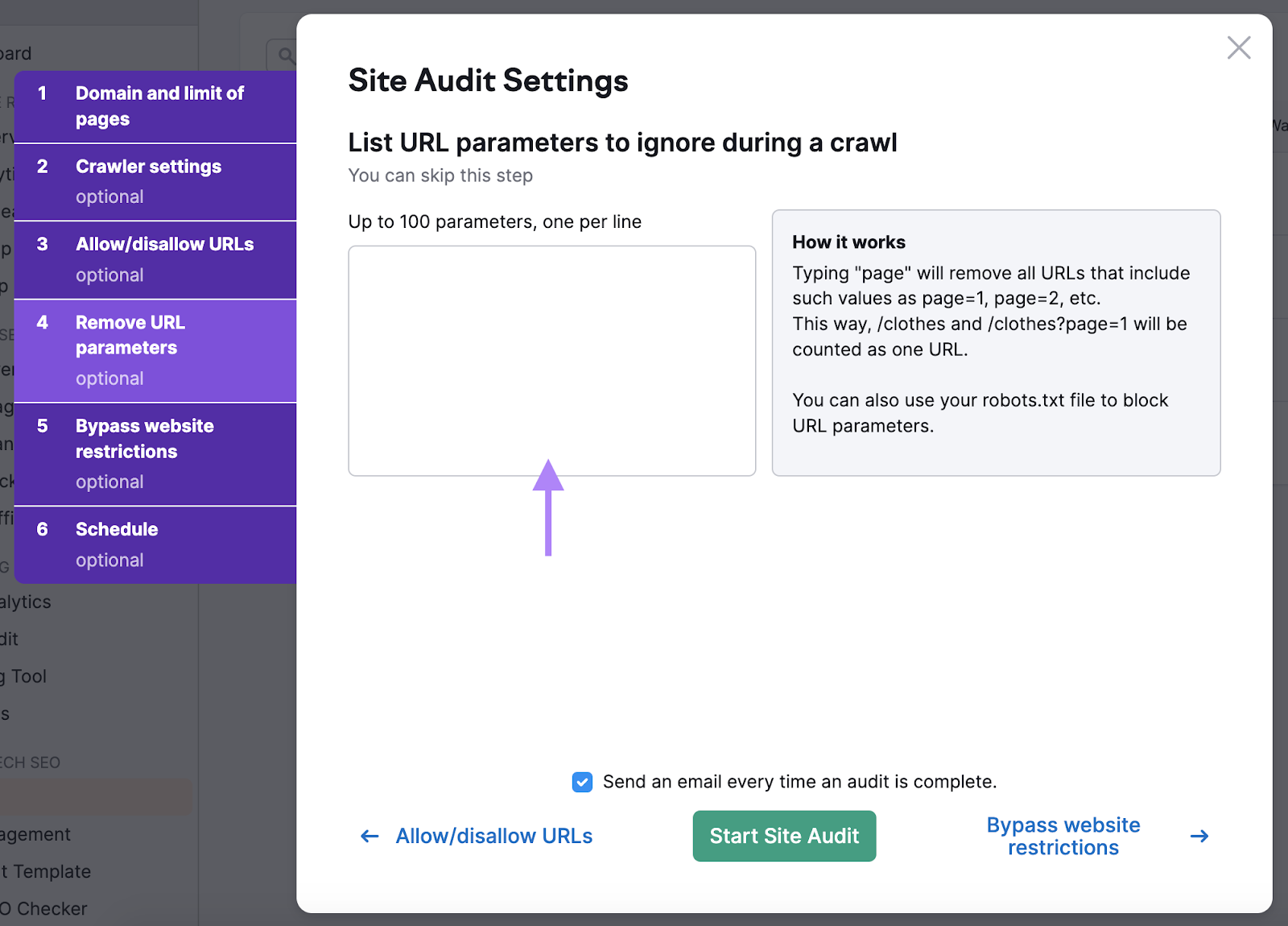

Remover parâmetros de URL

Remoção de parâmetros de URL garante que os bots não desperdicem o orçamento de rastreamento ao rastrear a mesma página duas vezes.

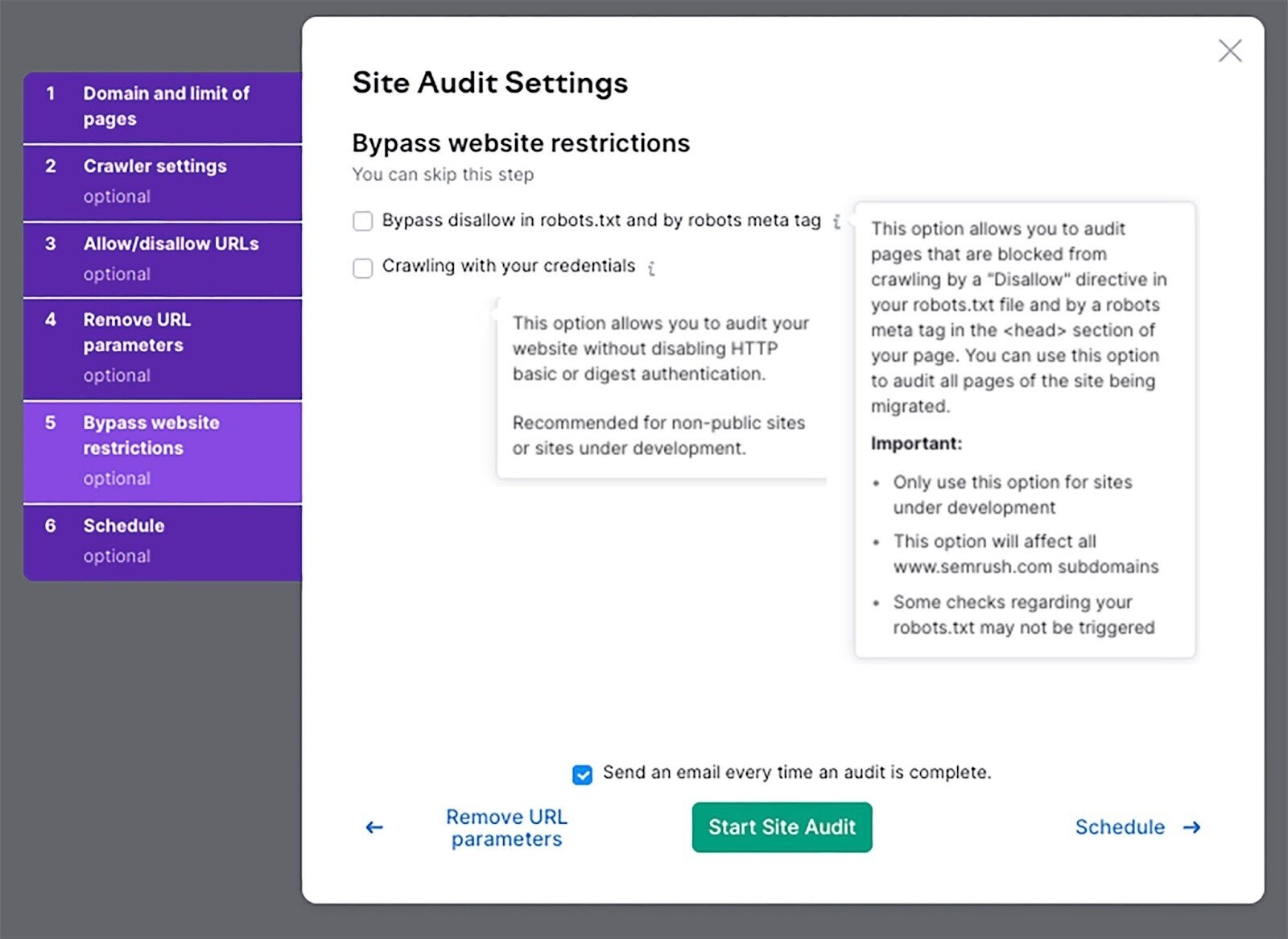

Ignorar restrições do site

Se o seu site ainda estiver em desenvolvimento, use essa configuração para executar uma auditoria.

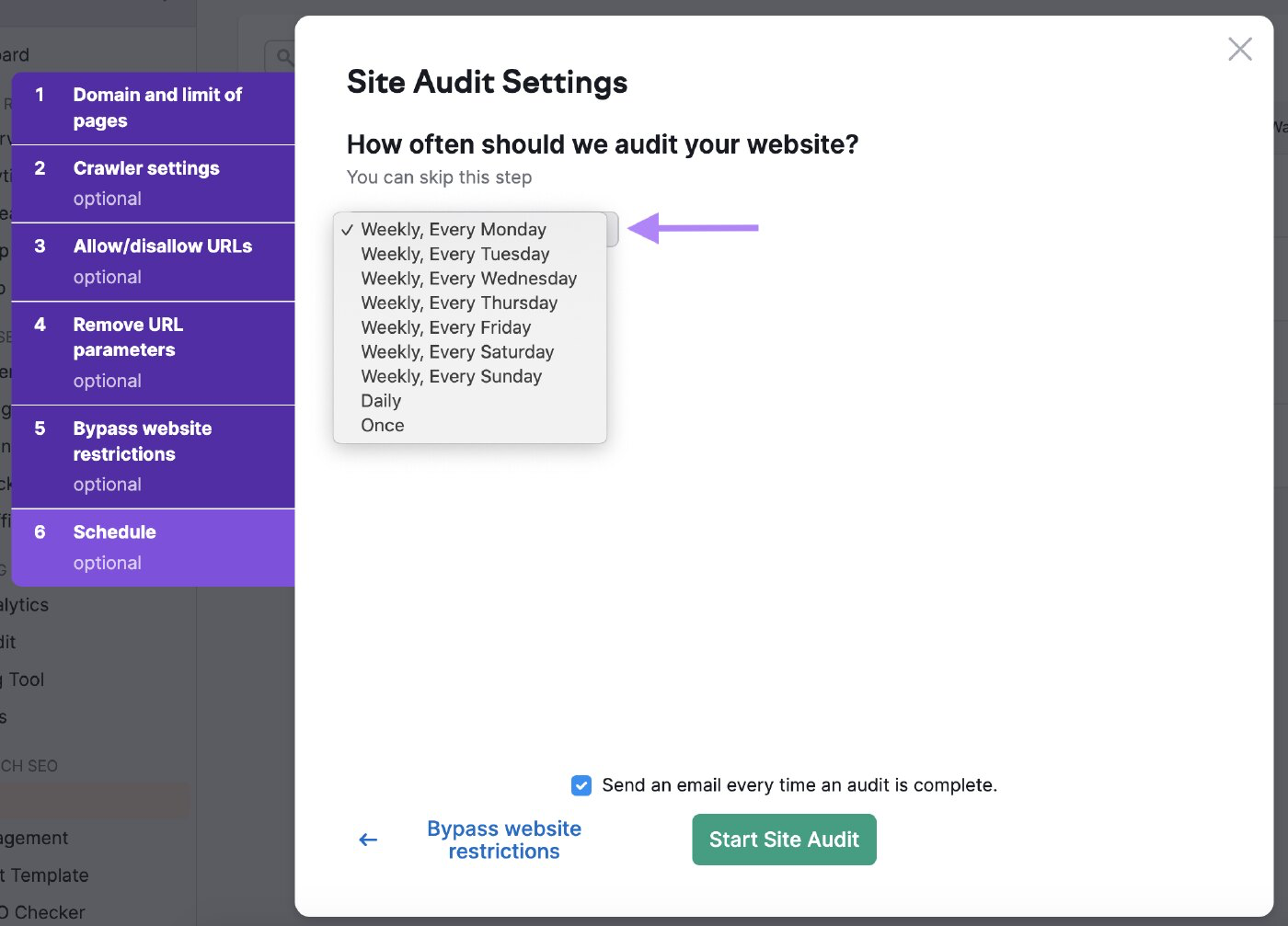

Agende suas auditorias

Você pode programar a frequência com que deseja que o bot audite seu site.

Agende-o com frequência para garantir que a ferramenta verifique a integridade do seu site regularmente.

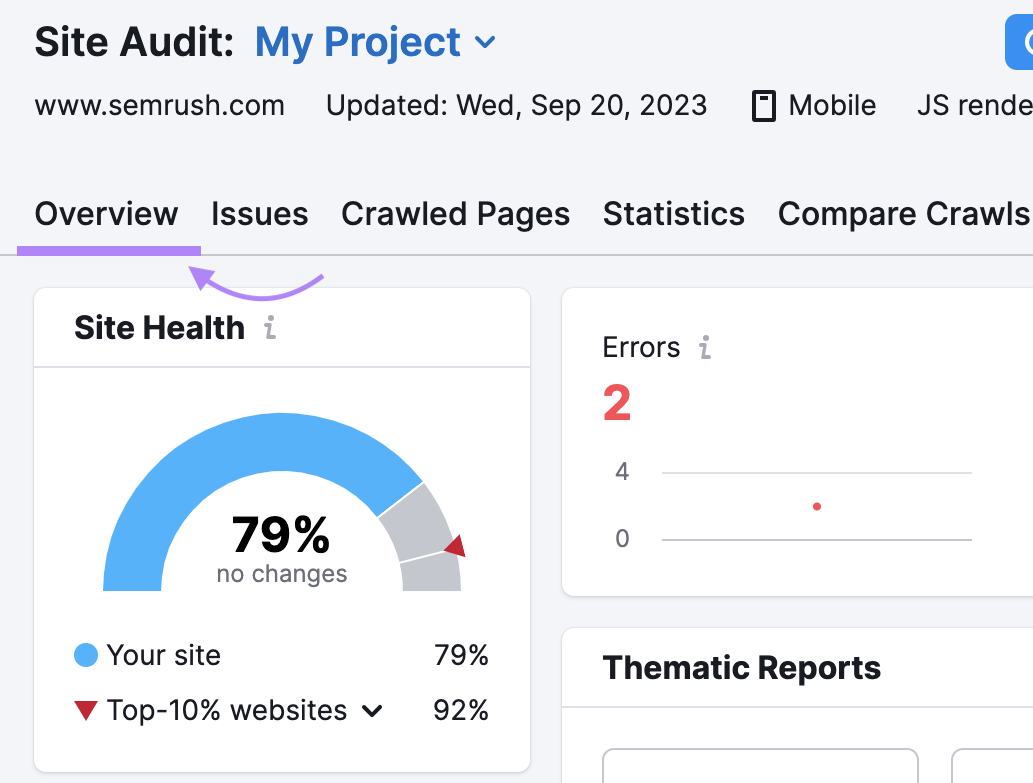

Analisar os resultados

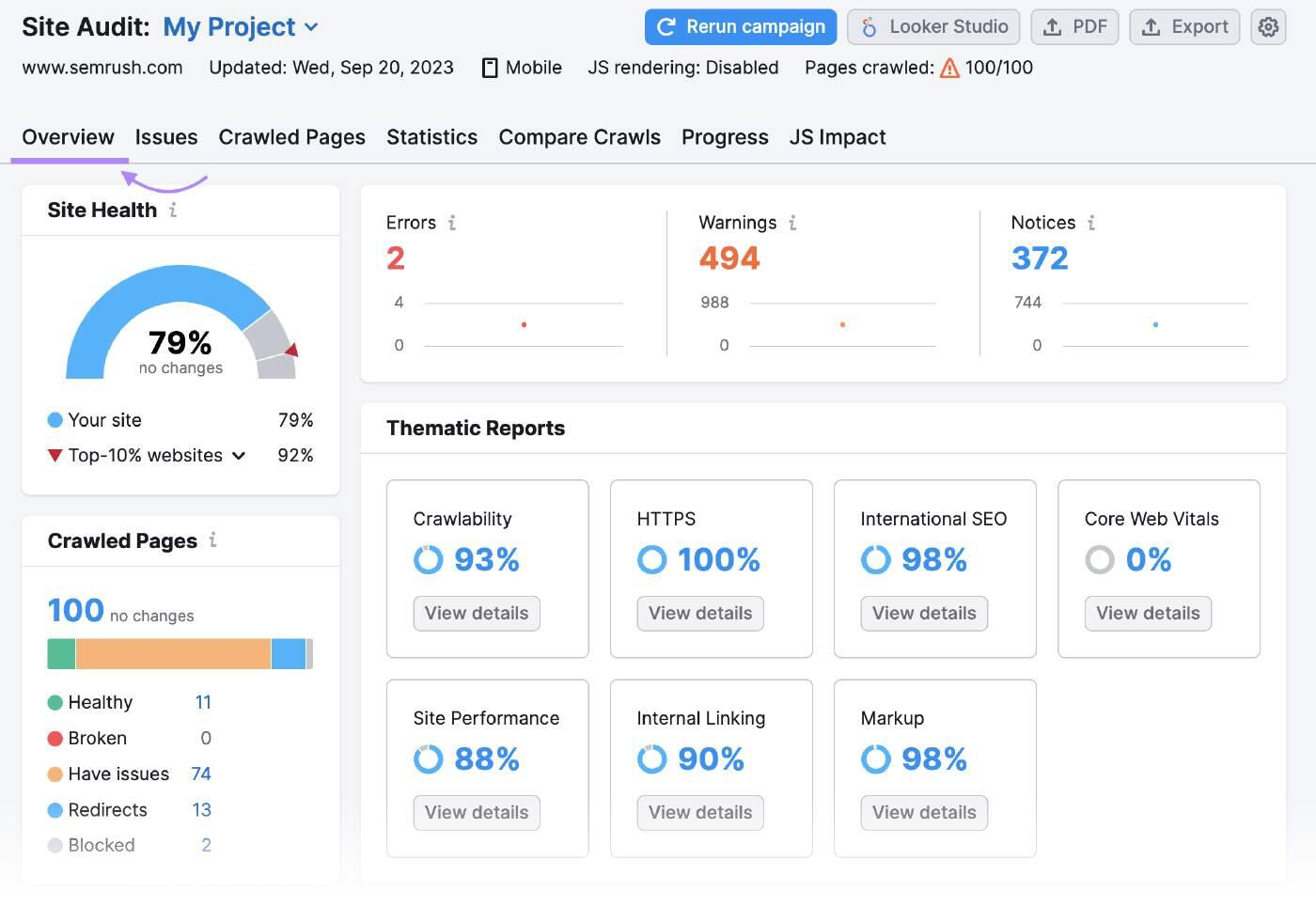

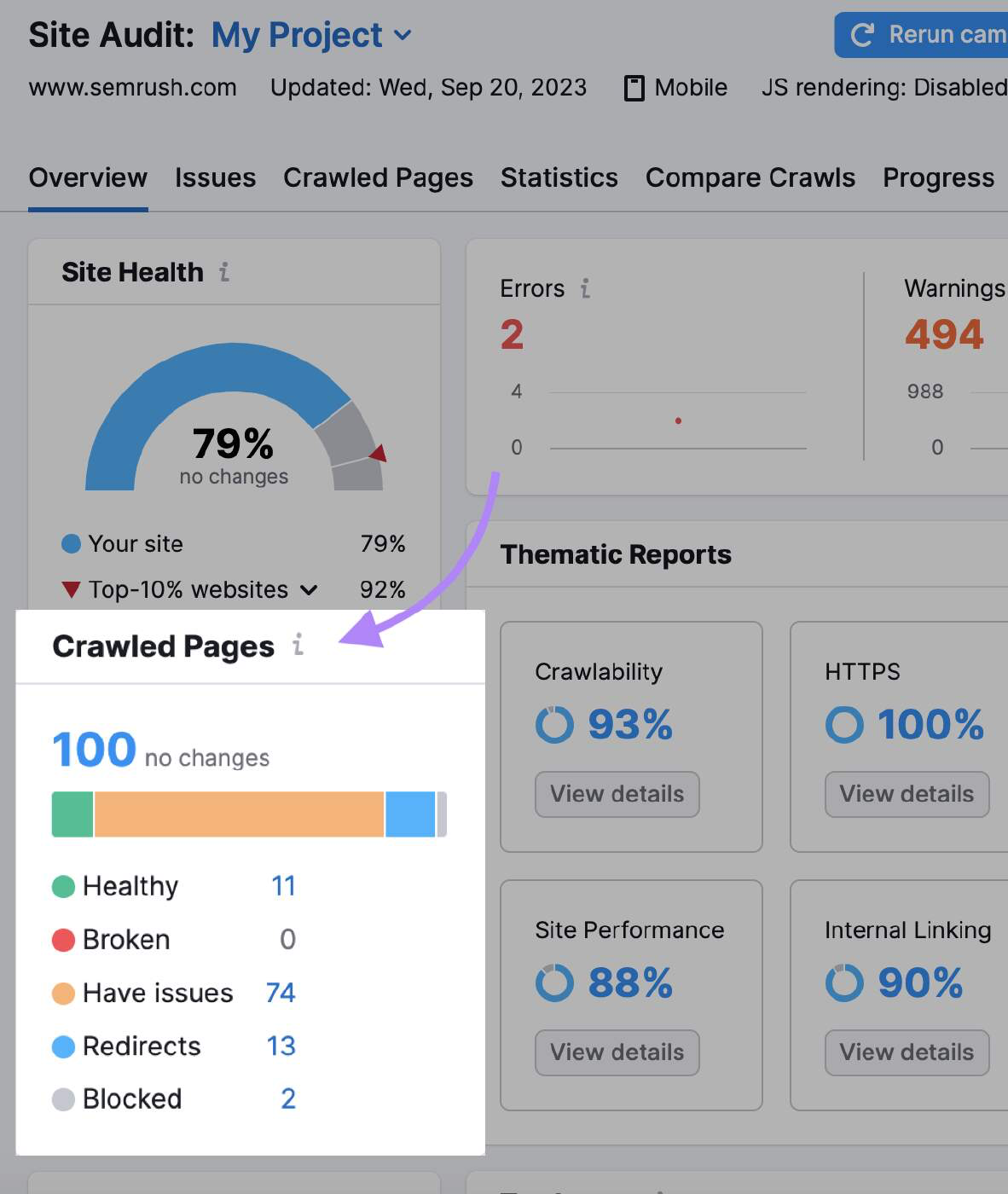

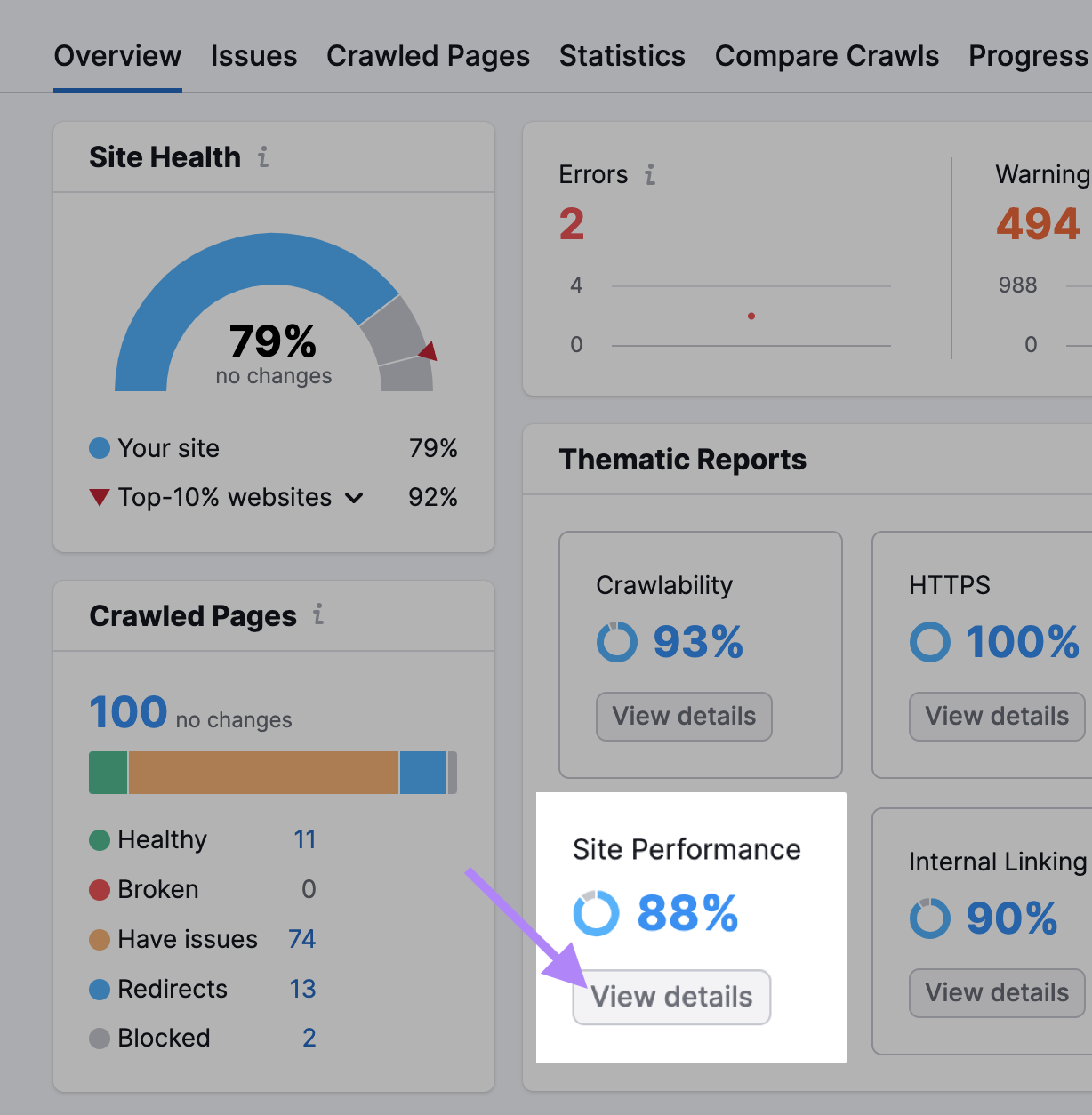

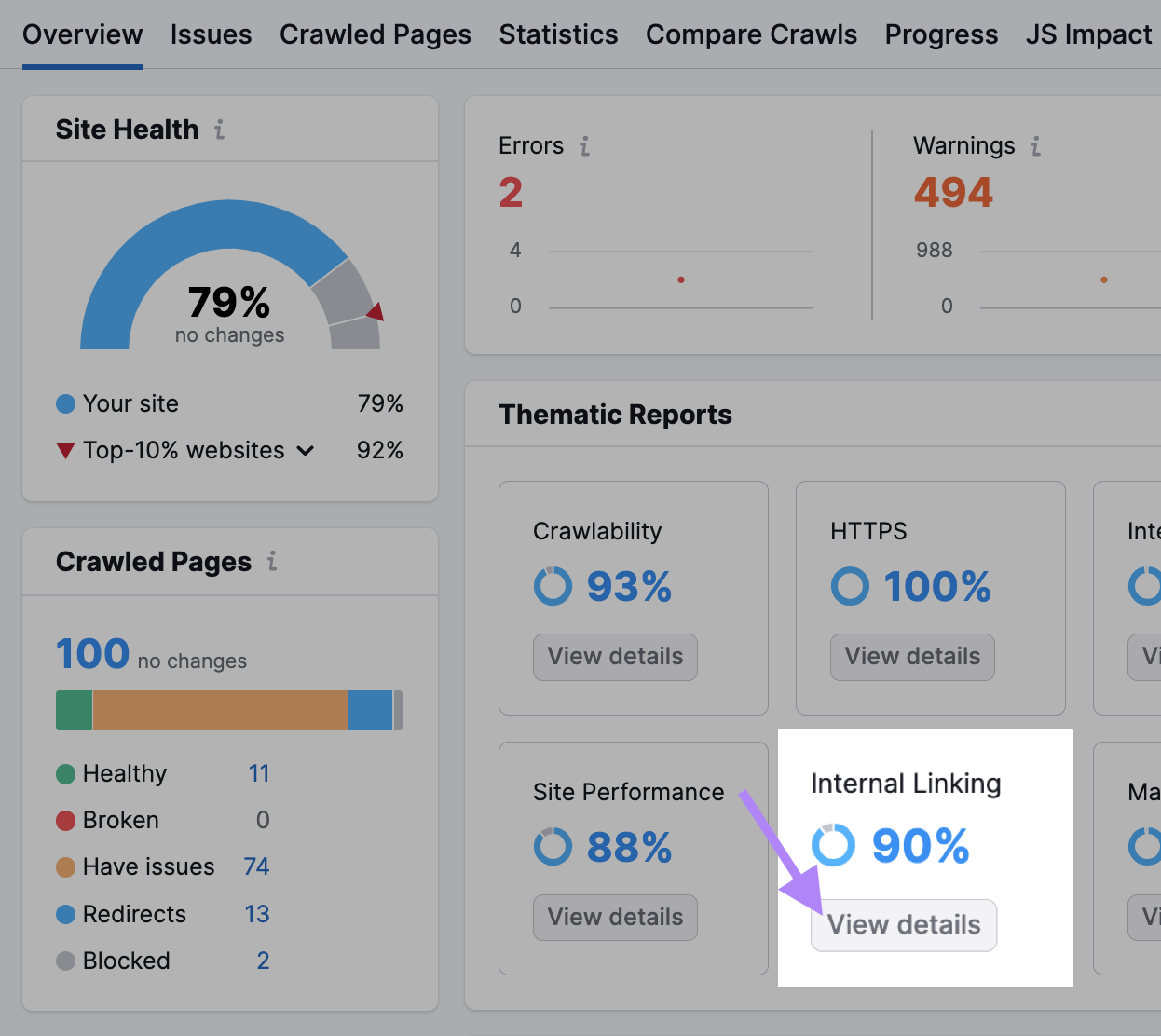

A visão geral da auditoria do site resume todos os dados que os bots coletaram durante o rastreamento.

"Crawled Pages" (Páginas rastreadas) informa a você quantas páginas estavam "saudáveis", "quebradas" e "têm problemas".

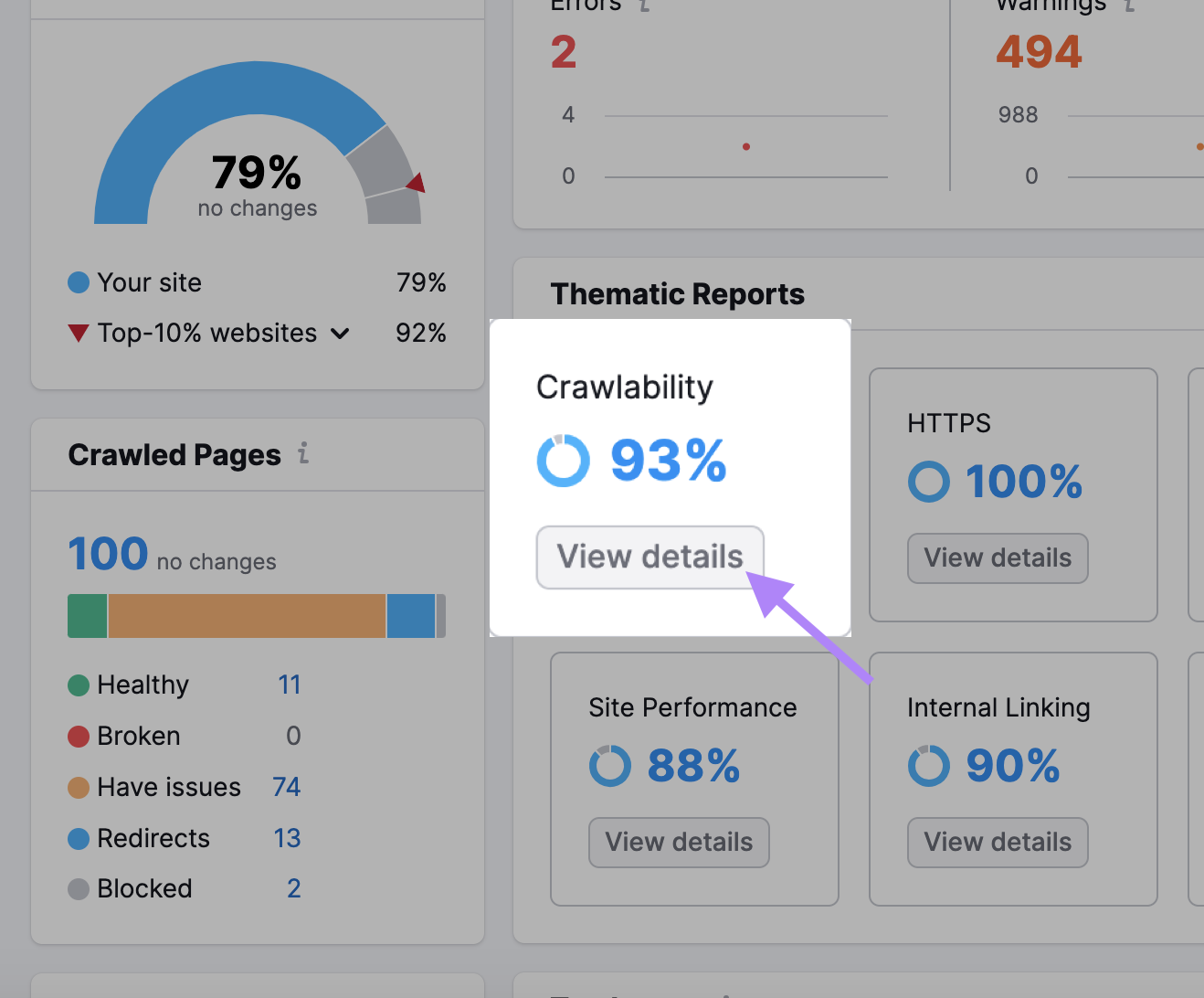

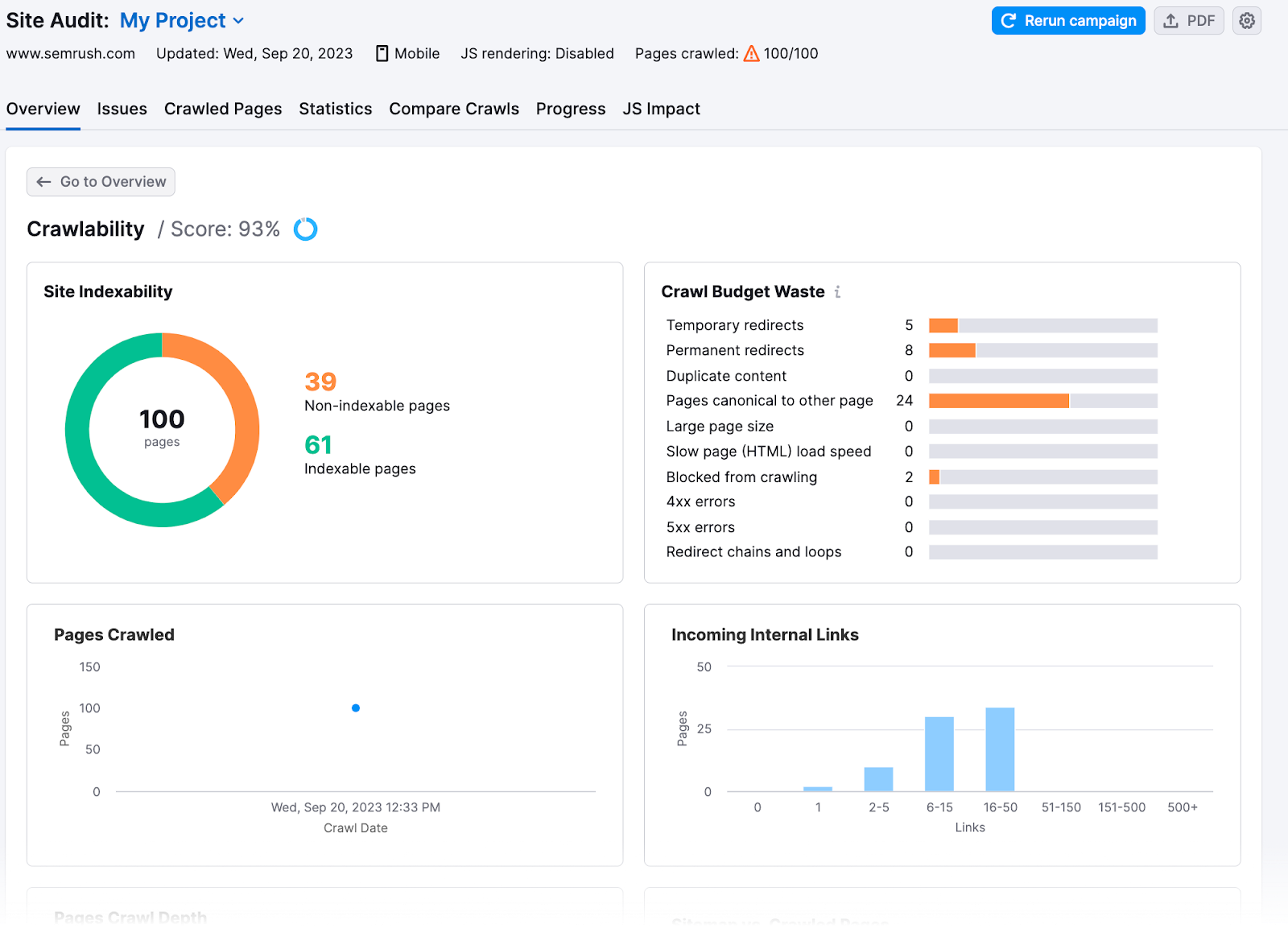

Você também obtém insights mais detalhados na seção "Crawlability".

Aqui, você descobrirá quanto do orçamento de rastreamento do seu site foi desperdiçado ou teve problemas de orçamento de rastreamento.

8 dicas para otimização do orçamento de rastreamento

Depois de conhecer os problemas do seu site, você poderá corrigi-los e maximizar a eficiência do rastreamento. Veja como você pode otimizar seu orçamento de rastreamento:

Verifique a velocidade do seu site

O rastreamento do Google é limitado pela largura de banda, pelo tempo e pela disponibilidade dos recursos do Googlebot. Se o servidor de um site responder às solicitações mais rapidamente, o Google poderá rastrear mais páginas.

Aumente a velocidade do seu site para melhorar a experiência do usuário(UX) e ajudar o Google a rastrear seu site mais rapidamente.

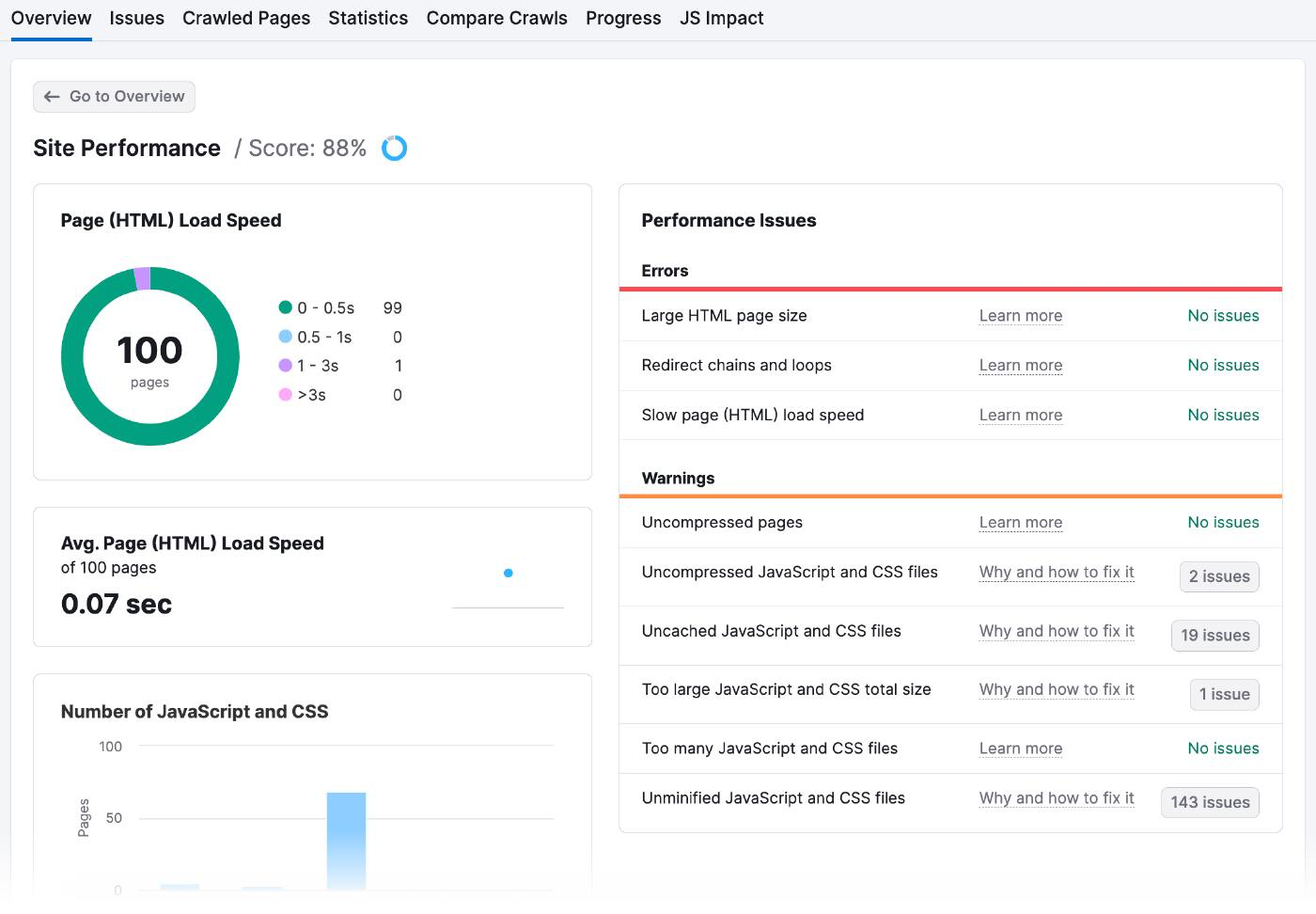

Vá para os resultados de Desempenho do site da auditoria do site para verificar os tempos de carregamento da página e quaisquer problemas de desempenho.

Esta é a aparência da página Site Performance:

Há muitas maneiras de melhorar a velocidade da página, inclusive:

- Otimizar suas imagens: Use ferramentas on-line como o Optimizilla para reduzir o tamanho dos arquivos sem pixelá-los. Garanta o dimensionamento adequado das imagens e escolha o tipo de arquivo apropriado (como JPEG, PNG ou GIF).

- Minimizar o código e os scripts: Examine o código do seu site para remover tudo o que for desnecessário ou redundante. Além disso, consolide vários arquivos em um só e use o cache do navegador para armazenar dados no computador do usuário, de modo que não seja necessário recarregá-lo todas as vezes.

- Usar uma rede de distribuição de conteúdo (CDN): Uma CDN é uma rede de servidores em diferentes partes do mundo. Quando alguém tenta acessar seu site, a CDN envia automaticamente o conteúdo do servidor mais próximo a ele, o que significa que o carregamento é mais rápido. Você precisará se inscrever em um serviço de CDN como o Amazon Cloudfront, fazer upload do conteúdo do seu site para os servidores deles e configurar seu site para usar os URLs da CDN em vez dos seus.

Aumente os links internos e os Sitemaps de página

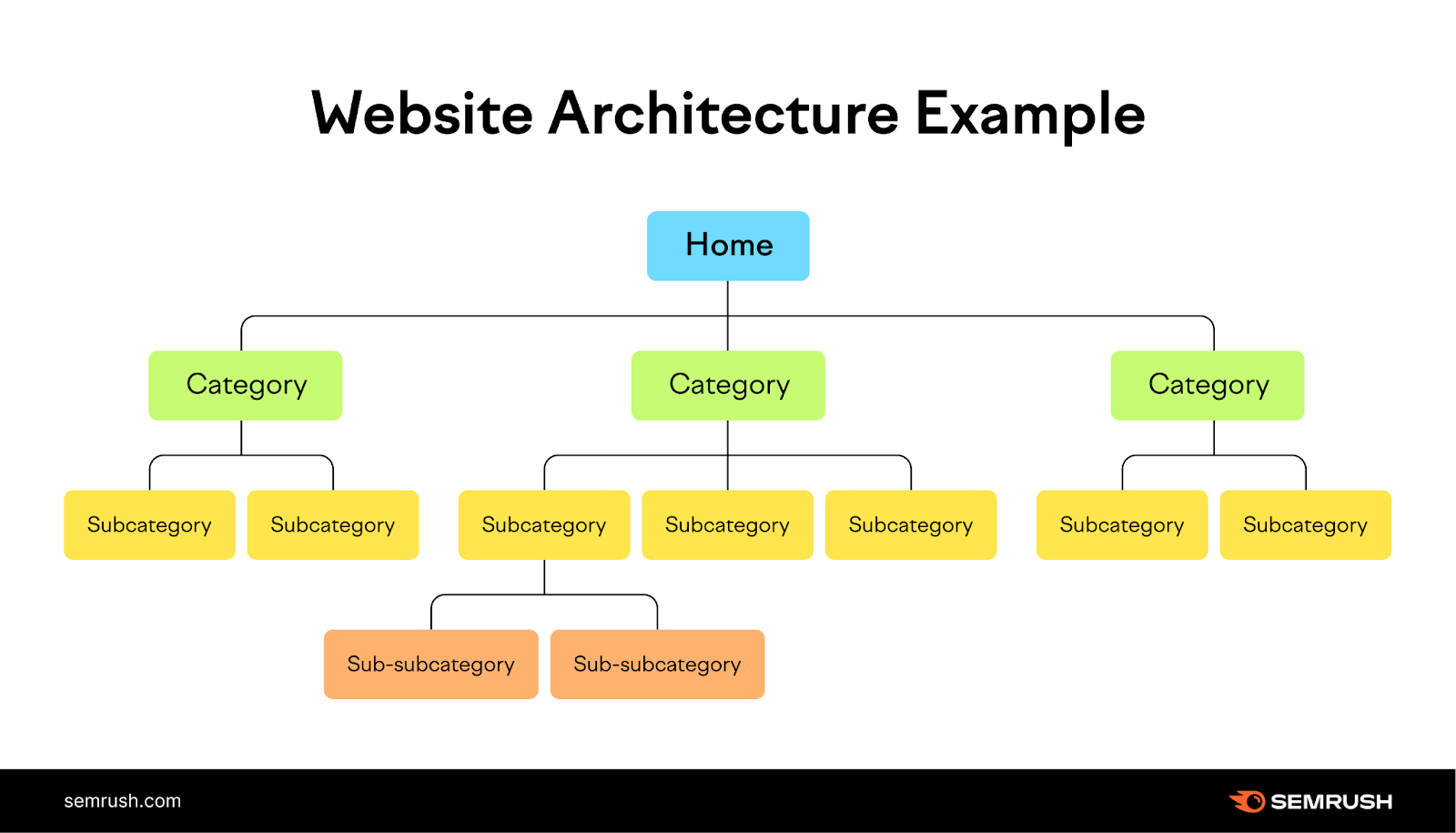

Se você adicionar uma estrutura lógica de links internos e um mapa do site, os bots saberão quais páginas indexar.

Os links internos fornecem um caminho natural para que os rastreadores dos mecanismos de pesquisa descubram e classifiquem novas páginas, enquanto os mapas de sites os ajudam a entender a estrutura e a hierarquia do seu conteúdo.

Imagine seu site como uma árvore, com a página inicial no topo e os galhos representando as diferentes categorias. Cada ramo deve levar a folhas menores (páginas) relacionadas a ele, criando uma estrutura clara e lógica para o seu site que seja fácil para os usuários navegarem.

Verifique a seção Link interno da Auditoria do site para ter uma ideia de como você fez isso.

Quando tiver esses dados, veja como você pode melhorar sua estrutura de links internos:

- As barras na Estrutura de links internos informam a você quais páginas são fortes, medíocres e precisam ser melhoradas. Adicione mais links internos às páginas das duas últimas categorias.

- Crie grupos de tópicos agrupando páginas relacionadas em um tópico e vinculando-as umas às outras. Digamos que você tenha um blog sobre vida saudável. Sua página de pilar principal poderia ser "Vida saudável" e seus grupos de tópicos poderiam ser "Nutrição", "Fitness" e "Saúde mental".

- É provável que o Google rastreie páginas com muitos links internos. São os que são novos e não têm links internos suficientes apontando para eles que podem enfrentar problemas. Por exemplo, se você adicionou recentemente um artigo sobre "Previsões de marketing para 2024", crie um link para ele a partir de suas páginas mais importantes para atrair a atenção e o tráfego do Google.

Oculte URLs que você não deseja nos resultados de pesquisa

Marque páginas de checkout, páginas de destino de anúncios, páginas de login e páginas de agradecimento como "noindex" para que não apareçam nos resultados dos mecanismos de pesquisa. Assim como outras meta tags, a tag "noindex" é inserida no cabeçalho de uma página da Web <>.

Essa tag é especialmente útil para páginas duplicadas ou outras páginas que você deseja manter privadas.

Embora os bots ainda rastreiem essas páginas para ver a tag, eles tomarão nota e limitarão o rastreamento delas no futuro.

Para informar aos mecanismos de pesquisa que não devem indexar uma página específica, use as meta tags robots com o atributo "noindex".

Coloque a seguinte tag no cabeçalho <> de sua página:

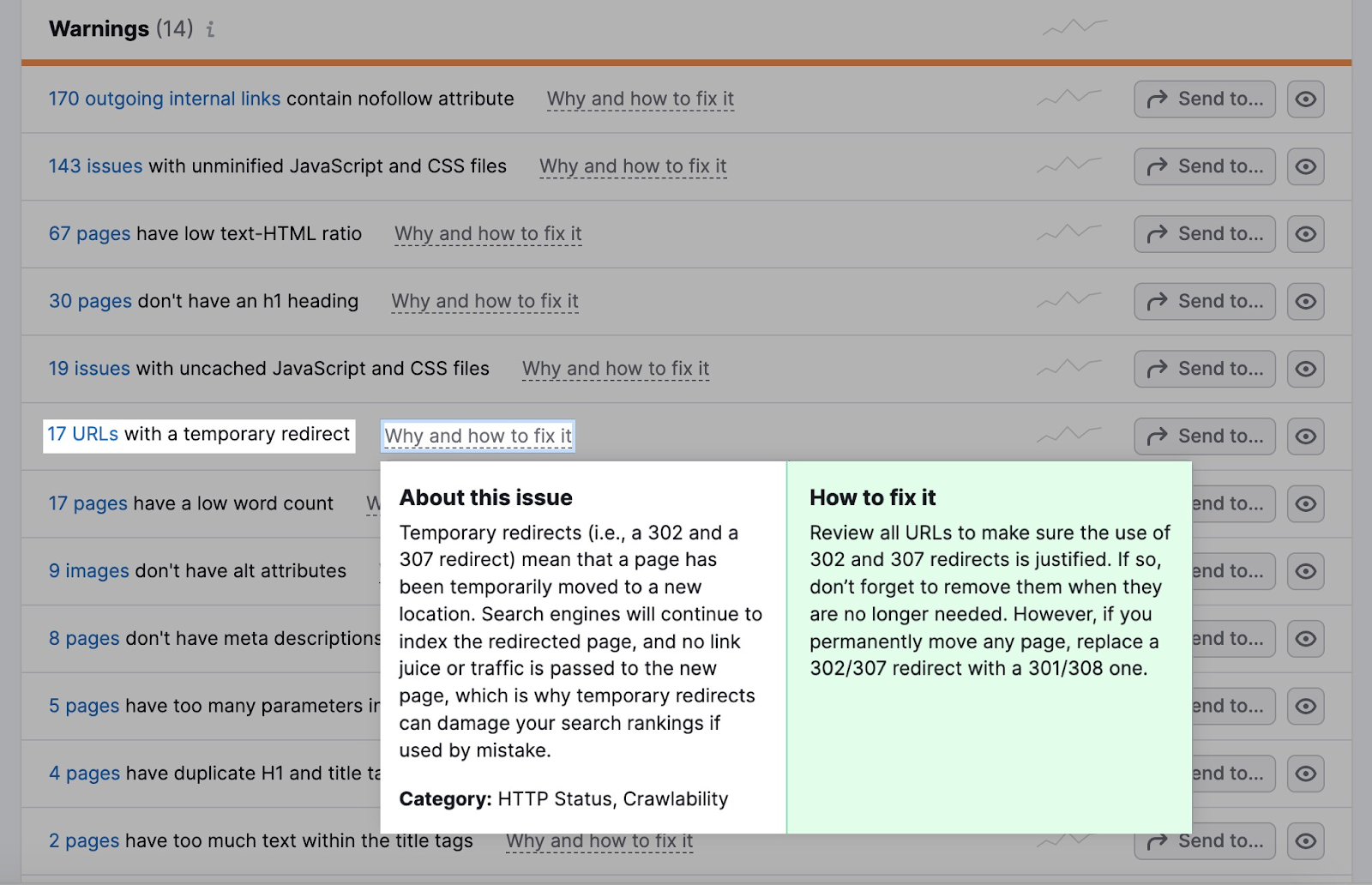

<meta name="robots" content="noindex">Reduzir redirecionamentos

Os redirecionamentos enviam automaticamente os bots de uma página da Web para outra. Se o bot visitar uma página que foi movida ou excluída, o redirecionamento o levará para o novo local da página ou para uma página que explica por que a página original não está mais disponível.

Os redirecionamentos exigem mais recursos do bot, pois eles estão visitando mais páginas do que o necessário.

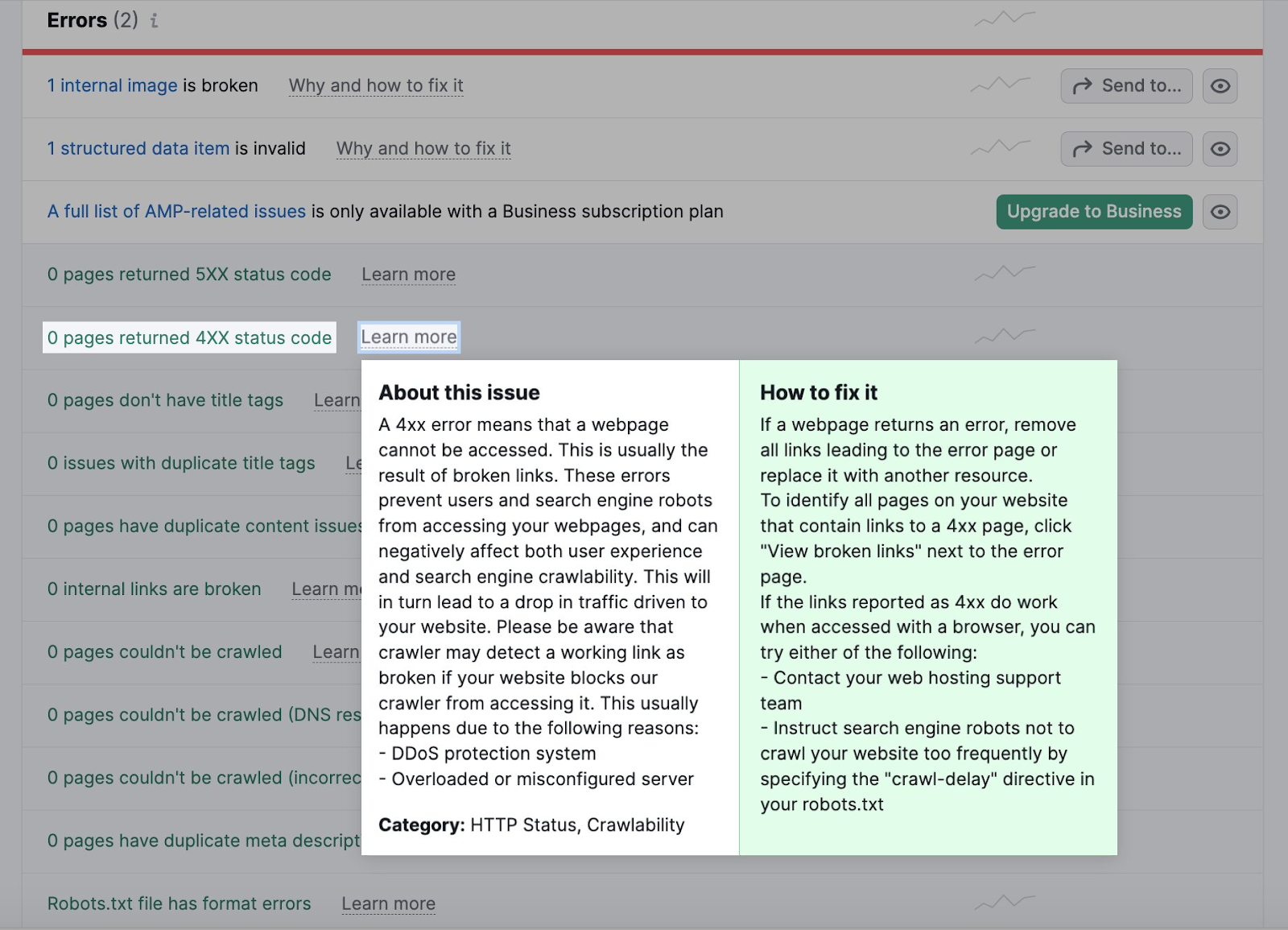

Vá para a guia Problemas em sua Auditoria do site.

A seção Warnings (Avisos ) informará a você quantos URLs têm um redirecionamento temporário.

A maioria dos navegadores seguirá um máximo de cinco cadeias de redirecionamento em um rastreamento.

Se você estiver usando redirecionamentos, verifique se eles são lógicos.

Digamos que um site de esportes tenha um artigo sobre um jogo de futebol do ano passado com o URL "example.com/football-game-2022".

No entanto, o jogo deste ano tem um URL diferente: "example.com/football-game-2023".

Para evitar confusão, o site pode configurar um redirecionamento para que qualquer pessoa que tente acessar "example.com/football-game-2022" seja automaticamente redirecionada para "example.com/football-game-2023".

Esse redirecionamento seria lógico.

Por outro lado, o site pode ter vários redirecionamentos desnecessários, como redirecionar de "example.com/football-game-2022" para "example.com/football-game-recaps" e depois para "example.com/football-game-2023".

Isso criaria uma cadeia de redirecionamento que desperdiça recursos e pode prejudicar a eficiência de rastreamento do site.

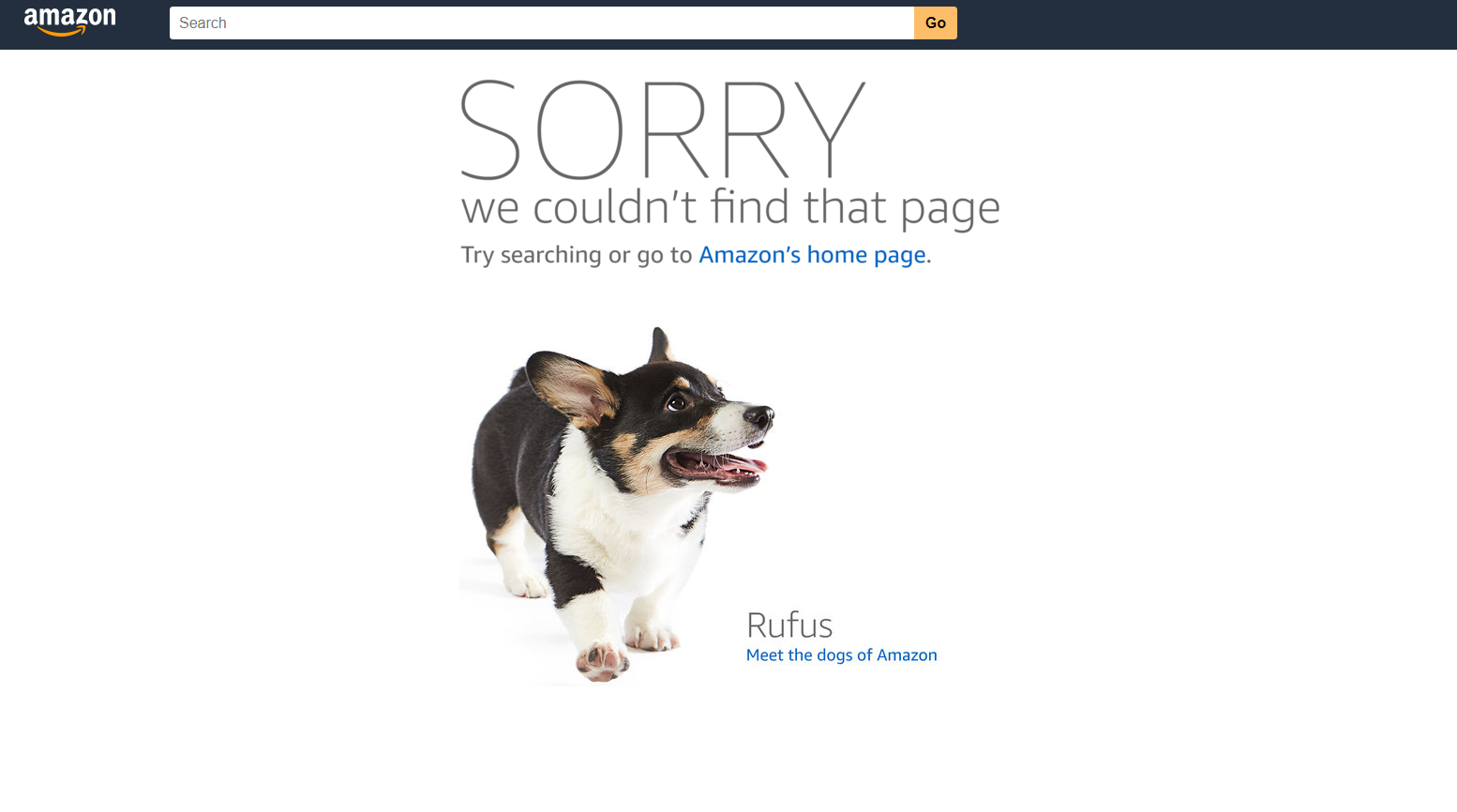

Corrigir links quebrados

Links quebrados são páginas que os bots não conseguem acessar. Eles prejudicam a capacidade de rastreamento e a experiência do usuário.

Quando os bots não conseguem acessar uma página, eles não podem rastreá-la e indexá-la. Muitos desses erros retardam o processo de rastreamento e consomem seu orçamento de rastreamento.

Um erro 404 na Amazon, por exemplo, tem a seguinte aparência.

Traduzimos este artigo do inglês. Clique aqui para ler o artigo original. Se você notar algum problema com o conteúdo, não hesite em entrar em contato conosco pelo e-mail report-osteam@semrush.com.

Você pode identificar links quebrados como erros 4xx na guia Problemas da Auditoria do site.

Clique no número de páginas para verificar se há páginas quebradas. Em seguida, substitua todos os links que levam à página quebrada por outra página.

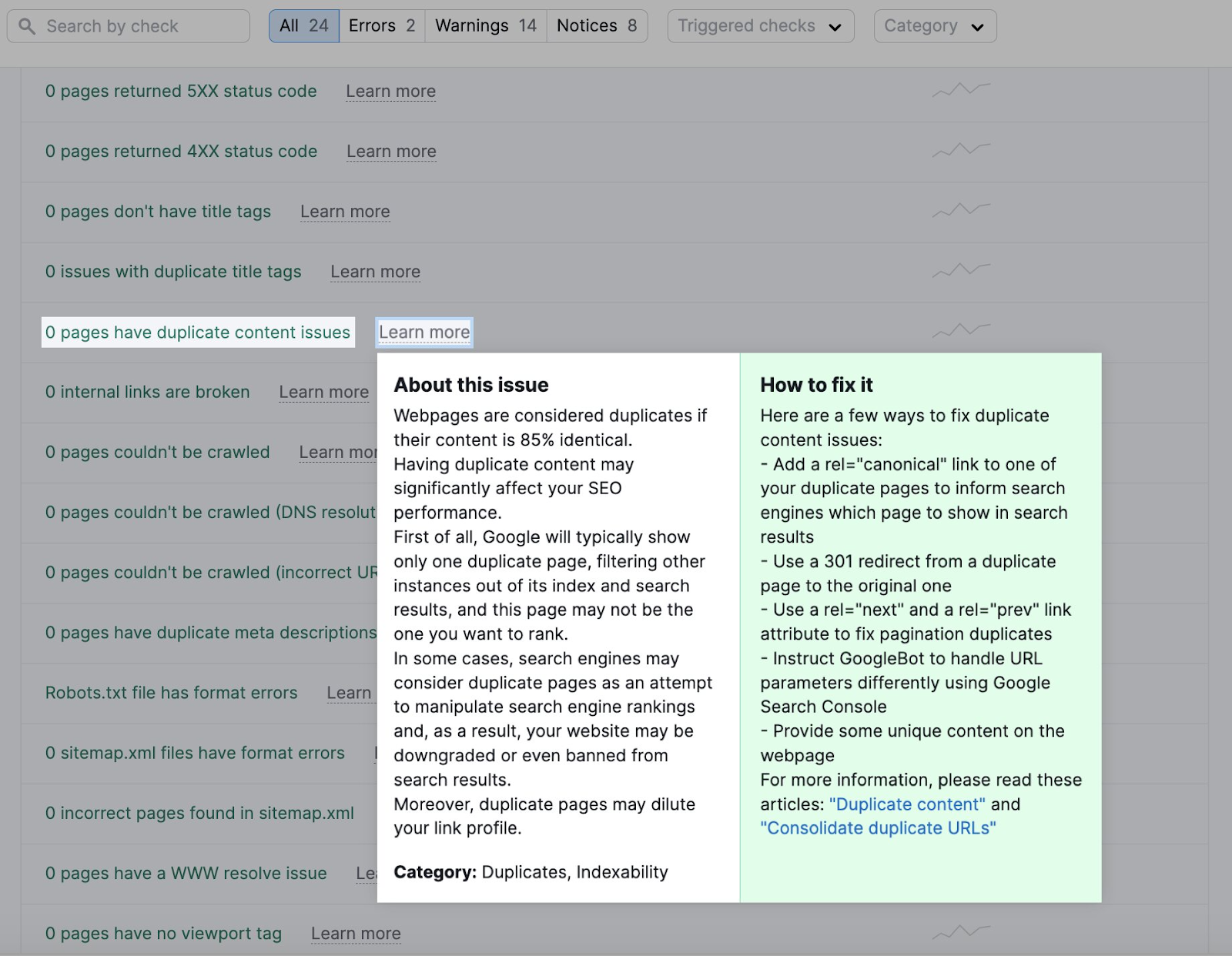

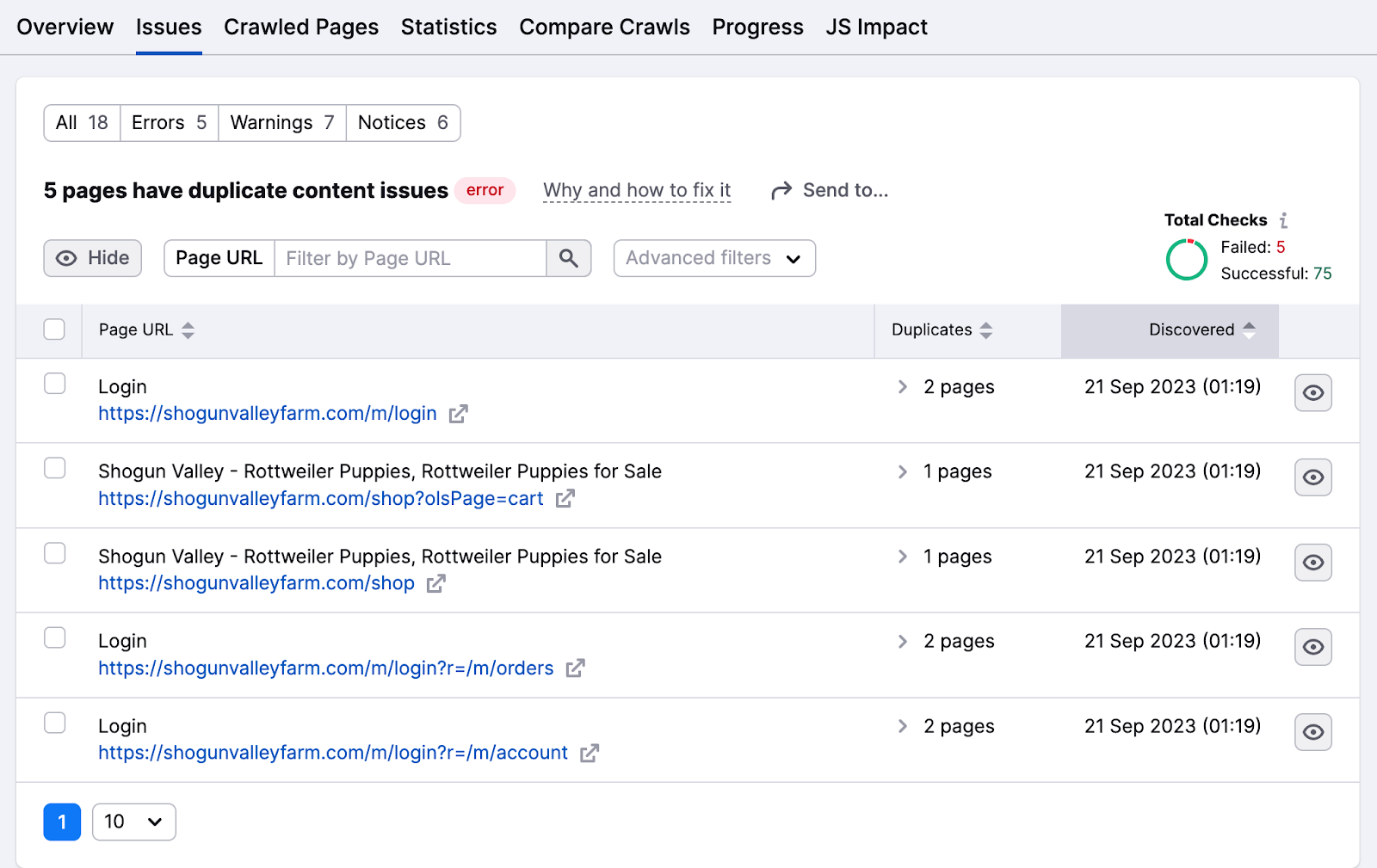

Eliminar conteúdo duplicado

Os bots consideram as páginas da Web duplicadas se o conteúdo for 85% idêntico. Reduza o conteúdo duplicado para evitar que os bots se confundam e rastreiem a mesma página várias vezes, desperdiçando tempo e recursos.

O conteúdo duplicado também afeta a indexação, pois os mecanismos de pesquisa podem considerá-lo uma tática de manipulação.

A guia Issues destaca todos os problemas de conteúdo duplicado.

Clique no número da página para verificar a lista de páginas com esses problemas.

Algumas maneiras de corrigir problemas de conteúdo duplicado incluem:

- Torne o conteúdo exclusivo, organizando-o em um grupo de tópicos ou atribuindo uma palavra-chave de foco

- Adicione a tag canônica "rel=canonical" no código HTML de uma dessas páginas para informar ao Google qual página você deseja que apareça nos resultados da pesquisa

- Adicione um redirecionamento 301 da página duplicada para a original (não é a melhor ideia para reduzir os redirecionamentos)

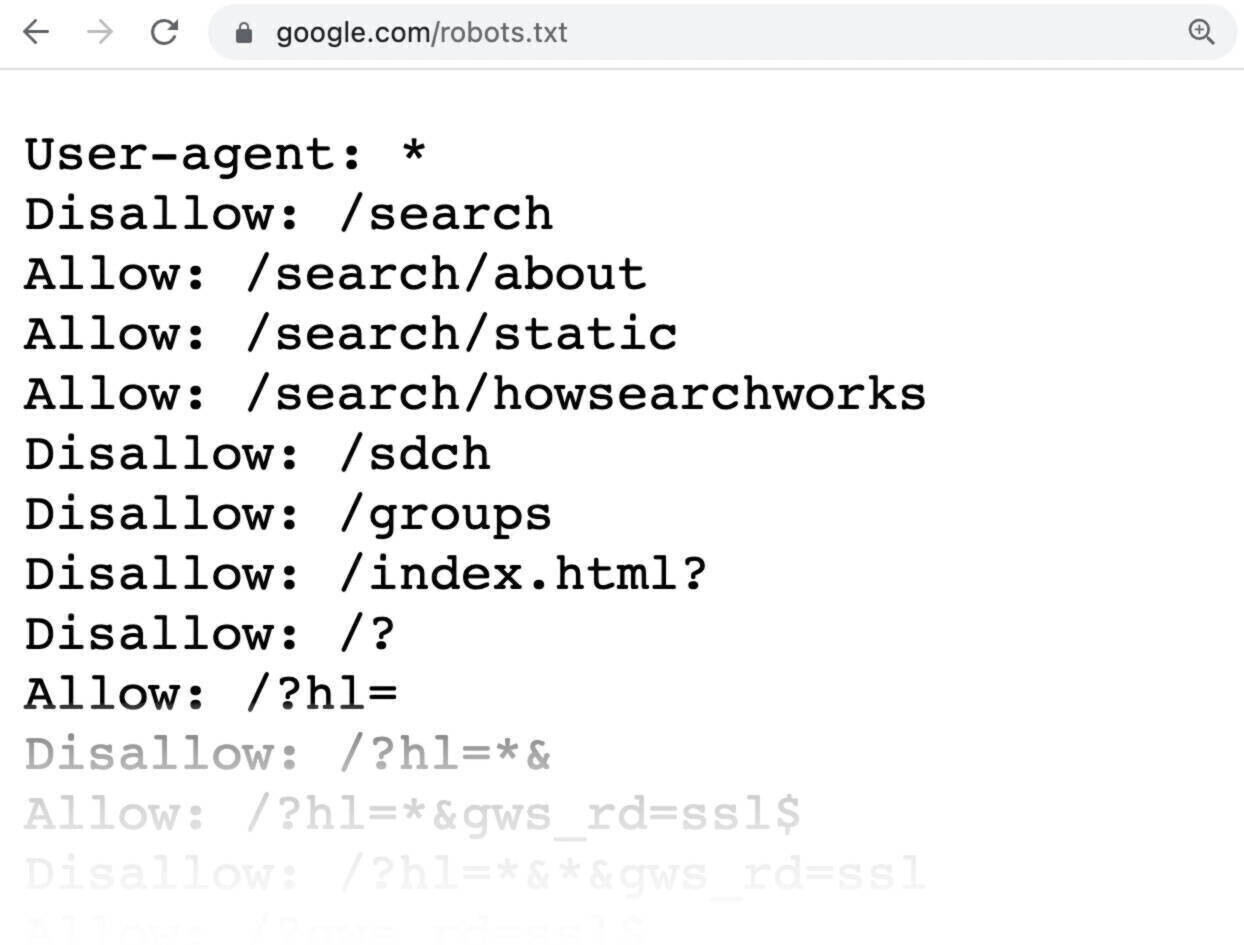

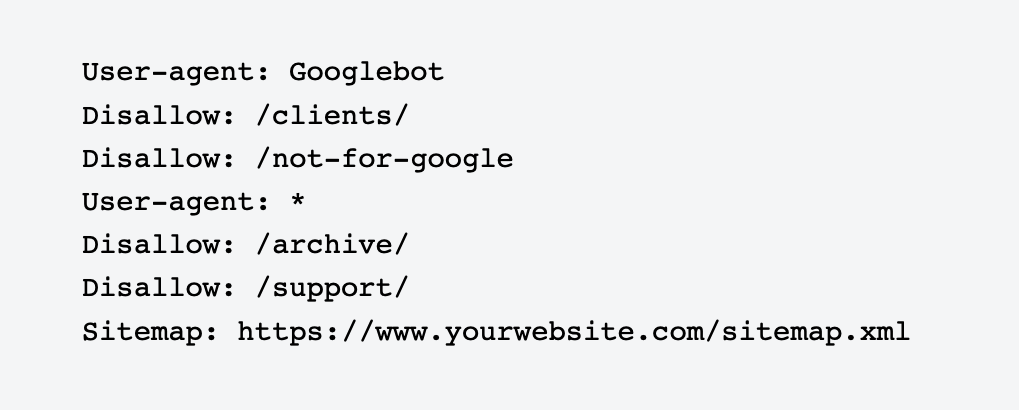

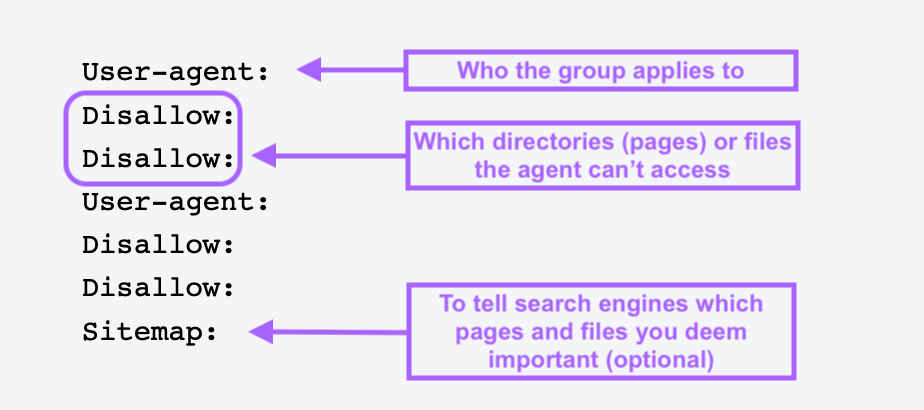

Use o Robots.txt

Um arquivo robots.txt é um arquivo de texto que você coloca no diretório raiz do seu site para informar aos bots dos mecanismos de pesquisa quais páginas ou seções do site não devem ser rastreadas ou indexadas.

Os arquivos Robots.txt ajudam você a bloquear páginas sem importância ou privadas, como páginas de login. Você não quer que os bots indexem essas páginas e desperdicem seus recursos, portanto, é melhor informar aos bots o que eles precisam fazer.

Veja como é um arquivo robots.txt simples:

All pages after Disallow especifica as páginas que você não deseja que sejam indexadas.

Para criar um arquivo robots.txt, use uma ferramenta geradora de robots.txt. Você também pode fazer um você mesmo.

Primeiro, abra um documento .txt com qualquer editor de texto ou navegador da Web e nomeie o documento como robots.txt.

Em seguida, adicione diretivas, que são várias linhas de instrução.

Quando você tiver um arquivo robots.txt, salve-o e carregue-o em seu site. O processo de upload depende de sua hospedagem na Web e da estrutura de arquivos do site.

Entre em contato com seu provedor de hospedagem ou pesquise on-line para obter ajuda sobre como fazer isso. Por exemplo, pesquise "upload robots.txt file to Shopify" para obter instruções específicas.

Evite páginas órfãs

As páginas órfãs não têm nenhum link interno ou externo apontando para elas. Essas páginas podem ser difíceis de serem encontradas pelos rastreadores, por isso é importante que você crie links para elas a partir de outras áreas do seu site.

Quando você encontrar a lista, crie links para essas páginas a partir de outros domínios de alta autoridade em seu site.

Você também pode vincular posts de blog relacionados, páginas de produtos e páginas de destino de categorias para facilitar a localização pelos rastreadores.

Maximize seu orçamento de rastreamento com a Semrush

Embora o Google normalmente consiga rastrear sites pequenos com facilidade, sites maiores e mais complexos devem adotar uma abordagem proativa para gerenciar seu desempenho de pesquisa.

Isso significa monitorar e otimizar regularmente vários aspectos técnicos de um site para garantir que ele permaneça acessível, bem estruturado e altamente visível.

Independentemente do tamanho da sua empresa, use a ferramenta Auditoria do site da Semrush para avaliar a integridade do site, otimizar a capacidade de rastreamento e corrigir erros antes que eles causem danos. Dessa forma, seu site continuará sendo um participante forte nas SERPs.