Como otimizar sites para busca orgânica sem se preocupar com as famigeradas atualizações do algoritmo do Google.

Por ser uma ciência não exata o mundo do SEO é repleto de mitos, equívocos e inverdades. Boa parte de tudo isso está relacionado às famigeradas atualizações do algoritmo.

É raro quando o Google vem a público e confirma uma atualização ou dá detalhes sobre ela. Portanto, na maioria das vezes são suposições, algumas precisas e outras verdadeiros tiros no escuro.

O que estou querendo dizer é que um bom trabalho de search engine optimisation não deve se preocupar com tais atualizações do algoritmo de ranqueamento orgânico do Google e sim ter como foco o usuário.

Disclaimer 1: focarei apenas nas atualizações Google devido ao baixo nível de utilização dos outros buscadores.

Uma rápida história sobre Atualizações Google a.k.a Google Updates

O algoritmo de posicionamento orgânico do Google está em constante evolução.Tais evoluções são conhecidas como Atualizações (Updates) e deixam certos SEOs loucos, enquanto outros são mais espertos e ganham dinheiro com isso.

Há também aqueles que não dão a mínima para essas atualizações, no caso eu.

O Google atualiza o algoritmo por dois motivos:

-

Aprimorar os resultados de pesquisa e retornar os melhores resultados de pesquisa possíveis para seus usuários.

-

Combater Webspam. Sim, combater os Black Hats que tentam enganar o algoritmo.

Disclaimer 2: Não sou contra Black Hat SEO, na verdade eu admiro quem o faz. Por quê? Por que esses caras são super arrojados e estão a todo momento testando maneiras de conseguir subir nos resultados orgânicos, mesmo que isso infrinja as diretrizes de qualidade do Google e gere penalização. Ao meu ver é sim uma forma de fazer SEO, mas eu não pratico pois trabalho com sites de clientes e não posso arriscar.

Se analisarmos rapidamente as últimas atualizações veremos que minha teoria tem fundamento:

-

Google Penguin: foco em combater webspam por meio de um filtro/algoritmo mais robusto para identificar links de má qualidade.

-

Google Mobilegeddon: foco em sites que ainda não são mobile friendly.

-

Google Mobile Speed: foco no tempo de carregamento mobile.

-

Google Medic Update: foco na autoridade, veracidade e confiabilidade do conteúdo de um site.

Não é que eu não dou a mínima para atualizações do algoritmo eu simplesmente não entro em pânico. Por quê?

Por que desde sempre fiz SEO com foco no usuário e no que faz sentido para o negócio e marca dos meus clientes.

Pode parecer o maior clichê de SEO, mas é assim que trabalho e é assim que nesses 12 anos de carreira nunca tive um site penalizado. Ajudei muitos a se recuperarem de penalizações, mas ser penalizado nunca.

Razão pela qual decidi escrever esse artigo e compartilhar algumas técnicas atemporais de SEO a prova de Google Updates.

Técnicas de SEO a Prova de Atualizações Google

Para facilitar a compreensão e consequinte implementação, organizei-as em categorias:

-

On-page

-

Conteúdo

-

Usabilidade

-

SEO Técnico

-

Off-page

Técnicas Atemporais de SEO On-page

<title>Titles</title>

Bons títulos continuam sendo a base da otimização on-page. Enquanto houver o link azul clicável esse elemento continuará a ser importante.

Sugestões de otimização:

-

Inclua a palavra-chave principal da página, de preferência no início

-

Crie títulos para os usuários e não buscadores. Foco no CTR.

-

Respeite o limite de 64 a 66 caracteres

<meta name="Meta Description" content="...">

Assim como os títulos, a meta description continua sendo de suma importância. Apesar de não se considerada um fator de ranqueamento é muito importante para atrair cliques.

Sugestões de otimização:

-

Inclua a palavra-chave principal da página e se possível suas variáveis

-

Descreva de forma sucinta a página em questão e o que o usuário irá encontrar ao clicar.

-

Inclua Calls to Action: Acesse, Visite, Saiba Mais …

-

Respeito o limite de 156 caracteres

Pro tip 1: Para e-commerce utilize os 4Ps do marketing para compilar suas meta descriptions

URLs

O terceiro elemento visível na SERP (páginas de resultados de pesquisa) continua e continuará sendo importante para otimização on-page.

Portanto, respeite algumas regras de otimização:

-

Trabalhe a palavra-chave principal da página

-

Evite URLs muito longas

-

Não utilize caracteres especiais (*ˆ&ˆ!?)

-

Crie URLs, evite deixar que a plataforma cria automaticamente do título da página (não está errado, mas se puder ajustar é melhor)

Conteúdo

Das heading tags à legibilidade do conteúdo, tudo é muito importante e continuará sendo enquanto o Google for um buscador.

Dito isso, não se preocupe com a repetição de um determinado e sim no contexto. Amplie a gama de termos utilizados na página para deixar o conteúdo cada vez mais completo.

Trabalhe sempre com uma keyword principal, keyword secundária, complementares e LSI keywords.

No artigo " Como fazer pesquisa de palavras-chave para busca semântica" explico no detalhe como fazer para elevar o nível de otimização do conteúdo em tempos de busca semântica.

Também sugiro que estudem o algoritmo TF-IDF. Em suma, ele calcula a frequência de um termo no seu conteúdo contra a frequência em todos os outros documentos que o Google já rastreou e indexou. Complicado né? Eu sei, por isso vai lá dá uma estuda.

Imagens

Uma imagem vale mais que …

Nunca foi tão importante otimizar imagens. Não só para a relevância da páginas mas também para a acessibilidade do site e para melhorar o posicionamento no Google Imagens, segundo campo de busca mais utilizado no planeta Terra.

Sugestões de otimização:

-

Trabalhe a tag Alt de forma descritiva, foi-se o tempo de incluir apenas a palavra-chave. Descreva a imagem no detalhe. #pracegover

-

Utilize legenda na imagem quando fizer sentido

-

O texto perto da imagem é muito importante

-

Trabalhe com dados estruturados. Ex: schema.org/ImageObject

Links Internos e de Saída

Dois dos maiores mitos do SEO. Link internos e de saída, são sim muito importantes para otimização e continuarão sendo enquanto o Google utilizar links para encontrar novas páginas.

Sendo assim, otimize os links internos de forma a dar relevância para as principais páginas do seu site. Breadcrumbs ajudam e links de dentro do conteúdo são importantíssimos.

E, não deixe utilizar links para outros sites sempre que necessário. Não se preocupem com a "perda do PageRank", referenciar suas fontes tem muitos mais peso que perder "link juice".

Técnicas Atemporais de SEO para Conteúdo

E-A-T resume tudo que temos que fazer.

Para que nunca ouviu falar, E-A-T é uma sigla para Expertise, Authoritativeness and Trustworthiness.

Em terráqueo, EAT é a maneira como o Google analisa a expertise, autoridade e confiabilidade do seu conteúdo.

Basicamente precisamos mostrar ao Google que nosso conteúdo é escrito por quem entende do assunto e tem fundamento. Até aí nada de novo, certo?

Entretanto, nunca foi tão importante a prova social do nosso conteúdo. O que quero dizer com isso?

-

Não basta ter uma página de autor. É preciso incluir links e referências que comprovam a autoridade do autor no segmento

-

O mesmo se aplica para páginas "quem somos". Não adianta incluir uma foto bonita da empresa e aquele texto maravilhoso. É preciso incluir referências que ajudem o Google e o usuário a validar que as informações são verdadeiras

-

Presença online da marca nunca foi tão importante

-

Focar na construção da marca e não na quantidade de palavras-chave.

Técnicas Atemporais de SEO de Usabilidade

Arquitetura de informação

Uma arquitetura de informação bem organizada ajuda o bot a rastrear o site com mais facilidade e o usuário a encontrar o que busca sem ter que pensar.

Portanto, evite criar uma estrutura com muitos níveis. O mito dos 3 níveis não existe. Mas quanto menos cliques o usuário precisar dar para chegar até uma página melhor.

Navegação

Uma boa arquitetura de informação é o primeiro passo para uma boa navegação. Sendo assim, trabalhe com menus de navegação, breadcrumbs (trilhas de navegação), paginação e filtros quando necessário.

Em suma, facilite a vida do usuário com uma navegação fluida e intuitiva.

Responsividade / Adaptabilidad

Básico, mas muito importante. Se o site ainda não é responsivo ou se adapta a diferentes tipos de tela as probabilidades de performar bem nos resultados orgânicos do Google é baixa.

Em tempos de mobile first inext, é importante garantir que a otimização da versão mobile é igual ou melhor que a do desktop. Para isso, recomendo uma ferramenta que ajuda analizar se o mobile está bem otimizado: https://zeo.org/seo-araclari/mfi/

Tempo de Carregamento

Ninguém gosta de acessar um site que demora para carregar, nem o Googlebot. Mas nosso foco aqui é o usuário.

Dito isso, análise a performance das páginas com ferramentas como Webpagetest.org, GTmetrix, Web.Dev e atua nas melhorias recomendadas.

Pro tip 2: Monitore no detalhe as métricas mais importantes de performance com CRux Reports.

Pro tip 3: Invista em um bom servidor. Uma VPS geralmente ajuda muito na performance. CDNs também.

Acessibilidade

Um dos pontos mais relevados do SEO, a acessibilidade é muito importante para otimização de um site.

Pense comigo, se o objetivo do Google é direcionar os usuários para os sites mais relevantes e de melhor experiência, ser acessível é primordial. Não acha?

Como aprimorar a acessibilidade do site?

Comece corrigindo os pontos reportados no relatório do lighthouse via web.dev.

Segurança

Um site seguro é bom para o Google, mas é melhor ainda para o usuário. Portanto, garanta que seu site utiliza o certificado de segurança SSL.

Assim, de simples.

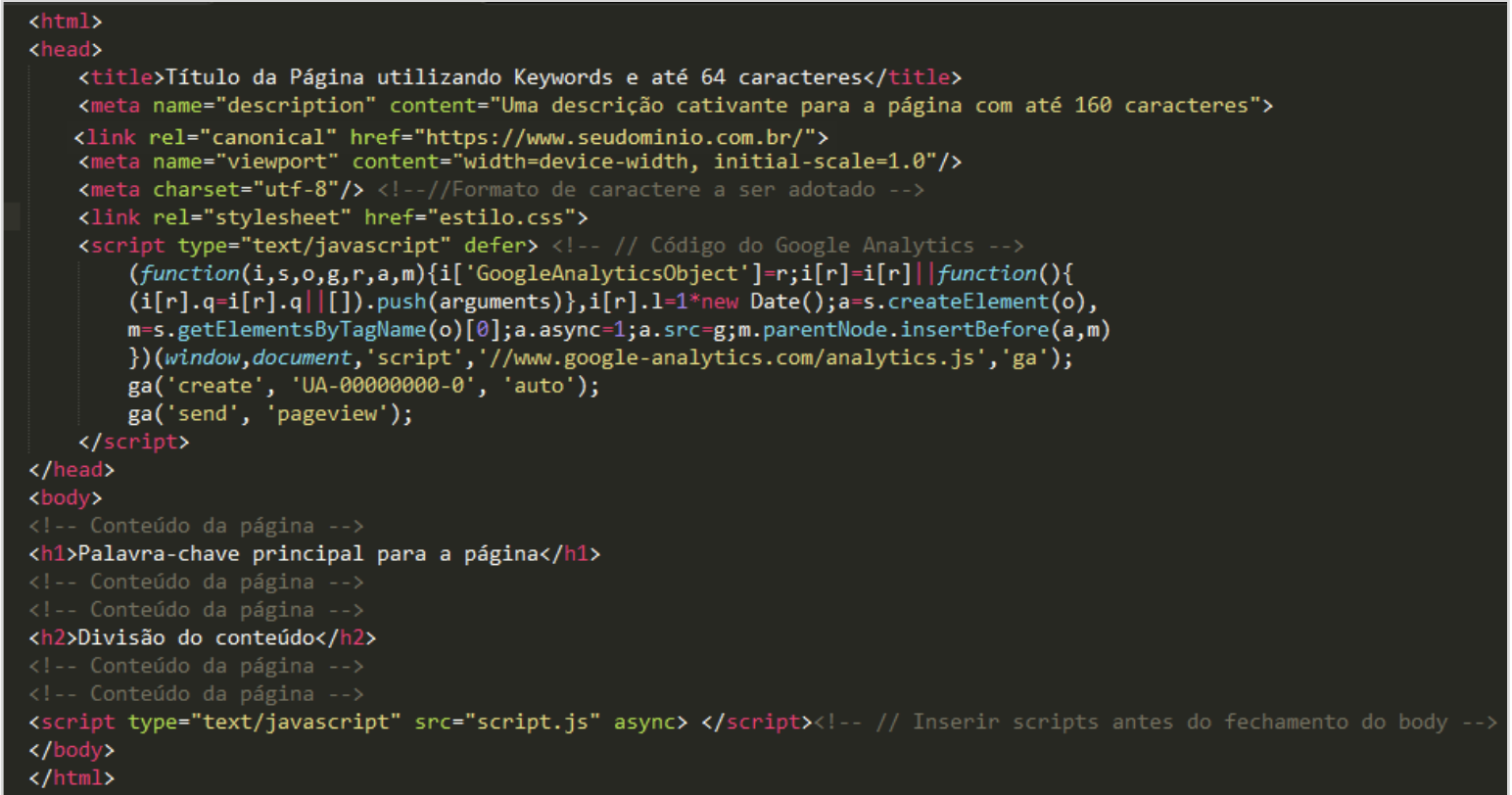

Técnicas Atemporais de SEO Técnico

Semântica do Código

Sim, a ordem das tags altera o viaduto.

Há quem diga que é preciosismo, mas eu sigo as melhores práticas e procuro organizar o código o máximo possível. Do title na abertura da <head> até os scripts adiados antes do fechamento do </body>.

Dados Estruturados

Das heading tags a estruturação de dados do consórcio Schema.org.

Apesar de ser uma técnica introduzida por volta de 2014 os dados estruturados são de suma importância e a tendência é que ganhem ainda mais relevância conforme o algoritmo evolua.

Mas atenção, se os dados estruturados forem implementados no intuito de enganar o bot isso gera penalização.

Um bom exemplo são as avaliações e comentários de produtos e serviços. Caso o Googlebot não consiga validar a origem dos comentários e avaliações as páginas que utilizam esses dados serão penalizadas.

Um bom ponto de partida é começar estudando as diretrizes do Google em relação aos dados estruturados.

Melhores Práticas W3C

Outro preciosismo, mas pensem comigo se um site contém várias não conformidades no código isso dificulta o rastreamento da página e acaba fazendo o Googlebot perder tempo desnecessário.

Portanto, quanto mais organizado for o código mais fácil para o bot.

Rastreamento, Indexação e Renderização

Robots.txt, sitemap.xml e testes de renderização. O importante é garantir que o bot está sempre rastreando, indexando e renderizando todas as páginas do site.

Logo, garanta que o seu robots.txt está bem configurado e não bloqueia arquivos de CSS e JS e, claro, páginas importantes.

O sitemap.xml deve ser gerado automaticamente e enviado ao Google via Search Console.

Não deixe de testar a renderização de páginas com a URL Inspection Tool do Search Console, com o ChromeDev Tools e comandos de busca como site: + intext:.

Disclaimer 3: Sim, só falei de bot aqui, por que a parte técnica é a única vertente do SEO na qual devemos focar mais no bot do que no usuário.

Técnicas Atemporais de SEO Off-page

Digam o que digam, os links externos continuam sendo extremamente relevantes para que uma página obtenha um bom posicionamento nos resultados orgânicos do Google.

Entretanto, é preciso pensar em link building com foco no usuário e não somente na conquista do link propriamente dito.

Sendo isso, um trabalho de conquista de links a prova de atualizações deve ter como base links com valor editorial, ou seja, referências editoriais em artigos de sites autoritários e relevantes ao segmento em que atua.

Dito isso, não se preocupem com métricas de vaidade do tipo Domain Authority e Page Authority. Foque no potencial que o link tem de receber clicks e gerar tráfego de referência, esse sãos os dois fatores mais importantes.

Para quem nunca ouviu falar, existe um algoritmo chamado "Reasonable Surfer" que calcula a probabilidade de um link receber um click. Isso sim é um fator importante para seus links, não o DA e PA da onde o link foi conquistado.

Referências sobre o Reasonable Surfer:

http://www.seobythesea.com/2016/04/googles-reasonable-surfer-patent-updated/

Conclusão

Se é bom para o usuário é para o Google, consequentemente faz sentido para a otimização do seu site.

E lembrem-se: O Básico é Avançado.

Assiste a Mesa Redonda "Segredos de Successo de Grandes Empresas de Ecommerce"